RAG-as-a-Service: Erschließen Sie generative KI für Ihr Unternehmen

Mit dem Aufkommen von Large Language Models (LLMs) und generativen KI-Trends kann die Integration von generativen KI-Lösungen in Ihrem Unternehmen die Effizienz von Arbeitsabläufen erheblich steigern. Wenn Sie neu auf dem Gebiet der generativen KI sind, kann die Fülle des Jargons einschüchternd wirken. In diesem Blog werden die grundlegenden Begriffe der generativen KI entmystifiziert und Sie erhalten eine Anleitung, wie Sie mit RAG-as-a-Service eine maßgeschneiderte KI-Lösung für Ihr Unternehmen entwickeln können.

Was ist Retrieval Augmented Generation (RAG)?

Retrieval Augmented Generation (RAG) ist ein Schlüsselkonzept bei der Implementierung von LLMs oder generativer KI in Geschäftsabläufe. RAG nutzt vorab trainierte Transformer-Modelle, um geschäftsbezogene Abfragen zu beantworten, indem relevante Daten aus Ihrer spezifischen Wissensbasis in den Abfrageprozess eingespeist werden. Diese Daten, auf die die LLMs möglicherweise nicht trainiert wurden, werden verwendet, um genaue und relevante Antworten zu generieren.

RAG ist sowohl kostengünstig als auch effizient und macht generative KI leichter zugänglich. Lassen Sie uns einige Schlüsselbegriffe im Zusammenhang mit der RAG untersuchen.

Wichtige Begriffe in RAG

Chunking

LLMs sind ressourcenintensiv und werden auf überschaubare Datenmengen trainiert, die als ‘Context Window’ bekannt sind. Das Context Window variiert je nach verwendetem LLM. Um den Einschränkungen zu begegnen, werden Geschäftsdaten, die in Form von Dokumenten oder Textliteratur vorliegen, in kleinere Teile zerlegt. Diese Chunks werden während des Abfrageprozesses verwendet.

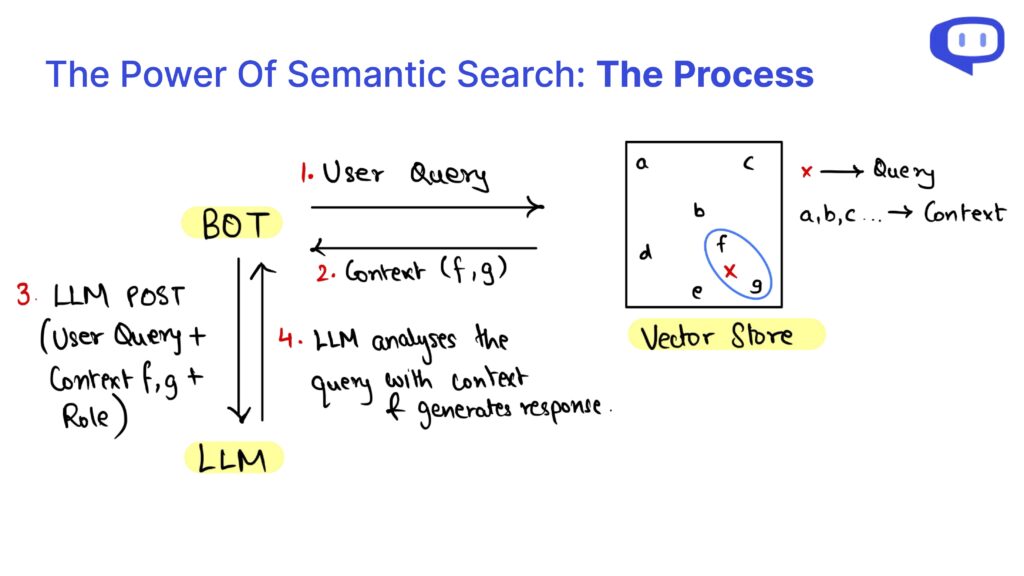

Da die Chunks unstrukturiert sind und die Abfragen sich syntaktisch von den Daten der Wissensdatenbank unterscheiden können, werden die Chunks mit Hilfe der semantischen Suche abgerufen.

Vektordatenbanken

Vektordatenbanken wie Pinecone, Chromadb und FAISS speichern die Einbettungen von Geschäftsdaten. Einbettungen wandeln Textdaten auf der Grundlage ihrer Bedeutung in eine numerische Form um und werden in einem hochdimensionalen Vektorraum gespeichert, in dem semantisch ähnliche Daten einander näher sind.

Bei einer Benutzeranfrage werden die Einbettungen der Anfrage verwendet, um semantisch ähnliche Chunks in der Vektordatenbank zu finden.

RAG-as-a-Service

Die Implementierung von RAG für Ihr Unternehmen kann entmutigend sein, wenn es Ihnen an technischem Fachwissen fehlt. An dieser Stelle kommt RAG-as-a-Service (RaaS) ins Spiel.

Wir von meetcody.ai bieten eine Plug-and-Play-Lösung für Ihre Geschäftsanforderungen. Erstellen Sie einfach ein Konto bei uns und fangen Sie kostenlos an. Wir kümmern uns um das Chunking, die Vektordatenbanken und den gesamten RAG-Prozess und sorgen dafür, dass Sie sich keine Sorgen machen müssen.

FAQs

1. Was ist RAG-as-a-Service (RaaS)?

RAG-as-a-Service (RaaS) ist eine umfassende Lösung, die den gesamten Retrieval Augmented Generation-Prozess für Ihr Unternehmen übernimmt. Dazu gehören das Chunking von Daten, das Speichern von Einbettungen in Vektordatenbanken und die Verwaltung der semantischen Suche, um relevante Daten für Abfragen zu finden.

2. Wie hilft das Chunking im RAG-Prozess?

Das Chunking unterteilt große Geschäftsdokumente in kleinere, überschaubare Teile, die in das Kontextfenster des LLM passen. Diese Segmentierung ermöglicht es dem LLM, relevante Informationen mit Hilfe der semantischen Suche effizienter zu verarbeiten und abzurufen.

3. Was sind Vektordatenbanken, und warum sind sie wichtig?

Vektordatenbanken speichern die numerischen Darstellungen (Einbettungen) Ihrer Geschäftsdaten. Diese Einbettungen ermöglichen die effiziente Suche nach semantisch ähnlichen Daten, wenn eine Anfrage gestellt wird, und gewährleisten so genaue und relevante Antworten des LLM.

Integrieren Sie RAG mit Leichtigkeit und Effizienz in Ihr Unternehmen, indem Sie die Leistungsfähigkeit von RAG-as-a-Service nutzen. Starten Sie noch heute mit meetcody.ai und verändern Sie Ihren Workflow mit fortschrittlichen generativen KI-Lösungen.