Gemini 1.5 Flash vs GPT-4o: Odpowiedź Google na GPT-4o?

Wyścig sztucznej inteligencji nasilił się, stając się grą w nadrabianie zaległości między dużymi graczami w branży technologicznej. Premiera GPT-4o tuż przed Google I/O nie jest przypadkowa. Niesamowite możliwości GPT-4o w zakresie multimodalności, a dokładniej omnimodalności, wywarły znaczący wpływ na konkurencję Generative AI. Jednak Google nie należy do osób, które się powstrzymują. Podczas Google I/O ogłosili nowe warianty swoich modeli Gemini i Gemma. Spośród wszystkich zapowiedzianych modeli, Gemini 1.5 Flash wyróżnia się jako najbardziej efektowny. Na tym blogu zbadamy najważniejsze cechy Gemini 1.5 Flash i porównamy go z Gemini 1.5 Pro i Gemini 1.5 Flash vs GPT-4o, aby określić, który z nich jest lepszy.

Porównanie Gemini 1.5 Flash vs GPT-4o

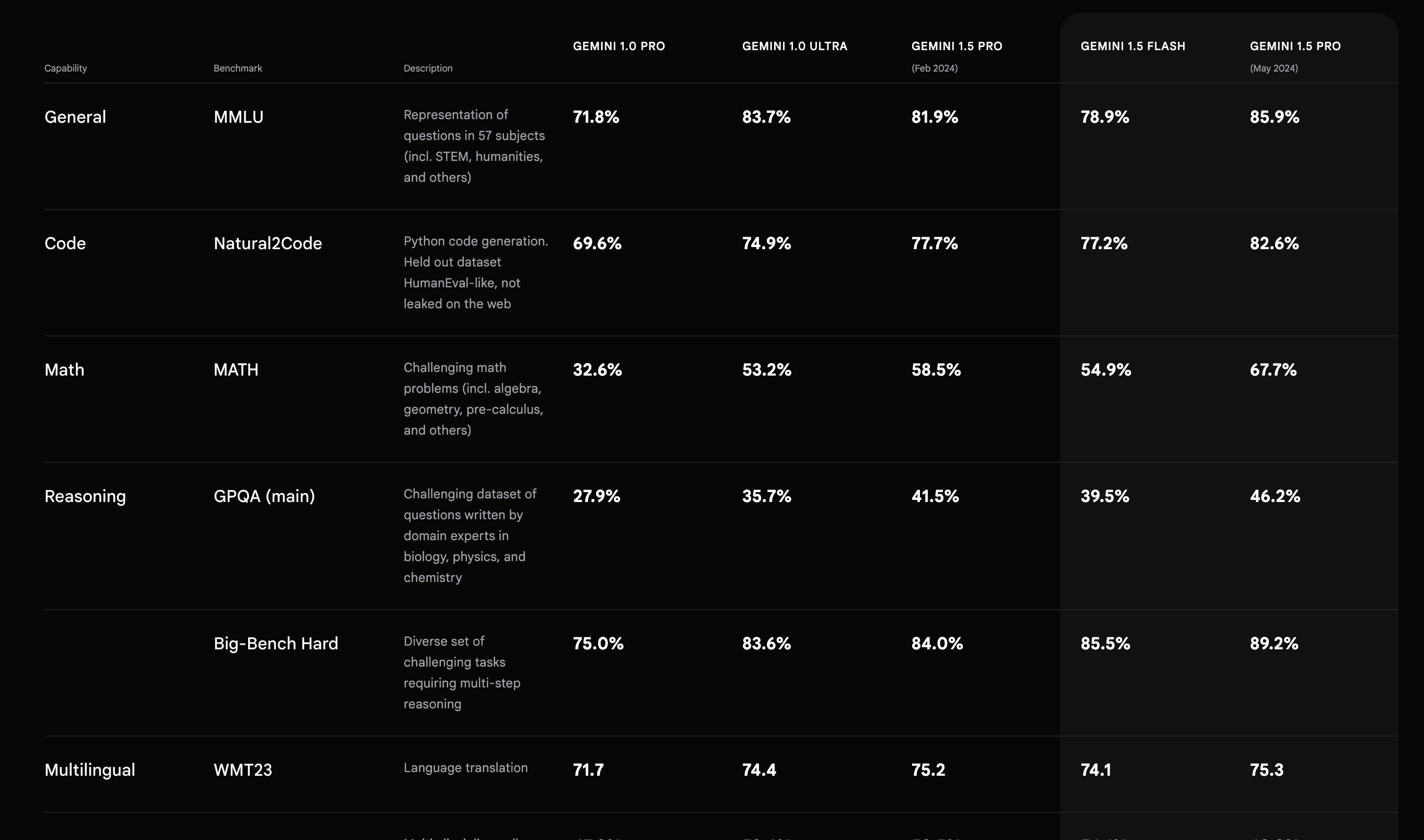

W oparciu o wyniki testów porównawczych opublikowanych przez Google, Gemini 1.5 Flash ma lepszą wydajność w zakresie dźwięku w porównaniu do wszystkich innych LLM Google i jest na równi z wychodzącym modelem Gemini 1.5 Pro (luty 2024) w innych testach porównawczych. Chociaż nie zalecamy całkowitego polegania na benchmarkach w celu oceny wydajności dowolnego LLM, pomagają one w ilościowym określeniu różnicy w wydajności i drobnych ulepszeniach.

Okno kontekstowe

Podobnie jak Gemini 1.5 Pro, Flash jest wyposażony w okno kontekstowe o pojemności 1 miliona tokenów, czyli więcej niż którykolwiek z modeli OpenAI i jest jednym z największych okien kontekstowych dla LLM klasy produkcyjnej. Większe okno kontekstowe pozwala na lepsze zrozumienie danych i może poprawić techniki innych firm, takie jak RAG (Retrieval-Augmented Generation) dla przypadków użycia z dużą bazą wiedzy poprzez zwiększenie rozmiaru fragmentu. Dodatkowo, większe okno kontekstowe pozwala na generowanie większej ilości tekstu, co jest pomocne w scenariuszach takich jak pisanie artykułów, e-maili i informacji prasowych.

Multimodalność

Gemini-1.5 Flash jest urządzeniem multimodalnym. Multimodalność pozwala na wprowadzanie kontekstu w postaci audio, wideo, dokumentów itp. LLM z multimodalnością są bardziej wszechstronne i otwierają drzwi do większej liczby zastosowań generatywnej sztucznej inteligencji bez konieczności wstępnego przetwarzania.

“Modele Gemini 1.5 są zbudowane do obsługi bardzo długich kontekstów; mają zdolność do przywoływania i rozumowania drobnoziarnistych informacji z co najmniej 10 milionów tokenów. Skala ta jest bezprecedensowa wśród współczesnych dużych modeli językowych (LLM) i umożliwia przetwarzanie długoformatowych danych wejściowych o mieszanej modalności, w tym całych kolekcji dokumentów, wielu godzin wideo i prawie pięciu dni audio”. – Raport DeepMind

Dabbas = wagon kolejowy w języku hindi. Demonstracja multimodalności i wielojęzyczności.

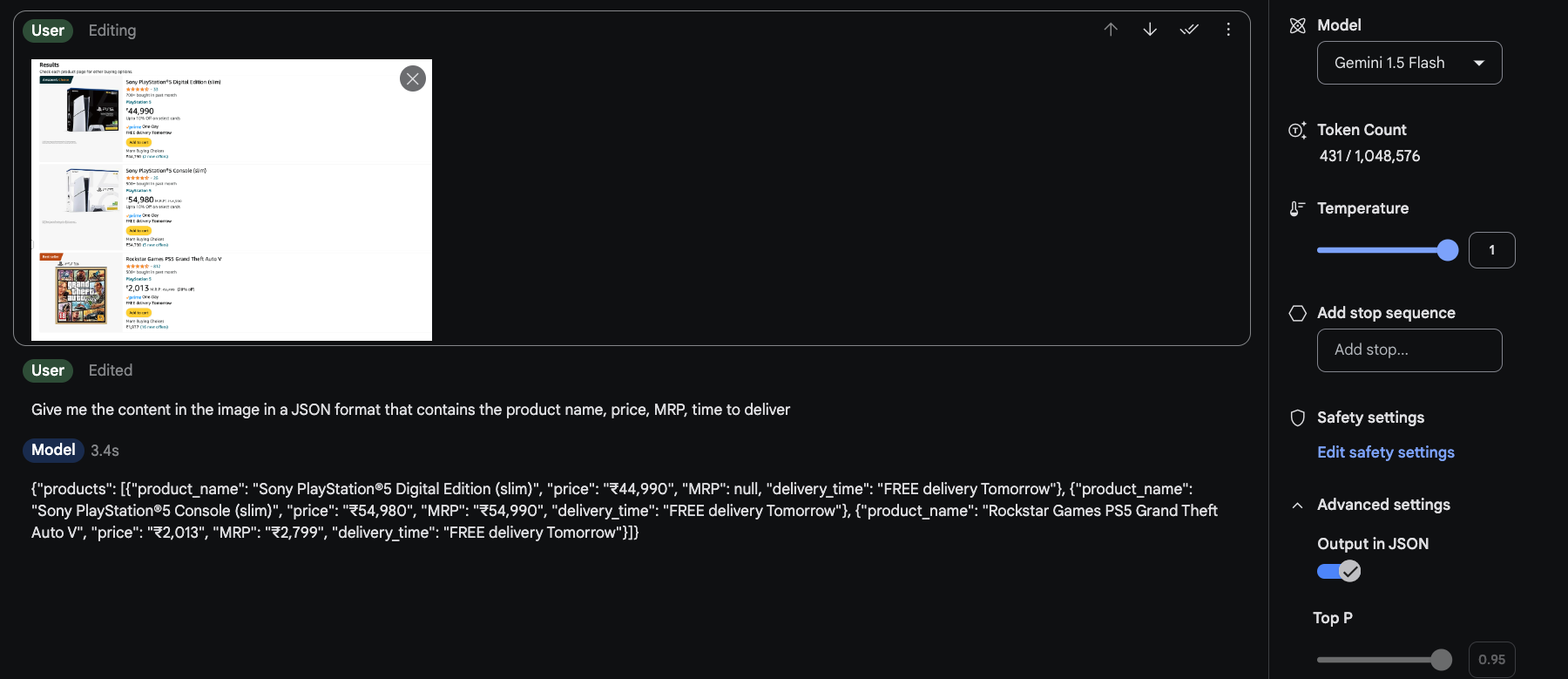

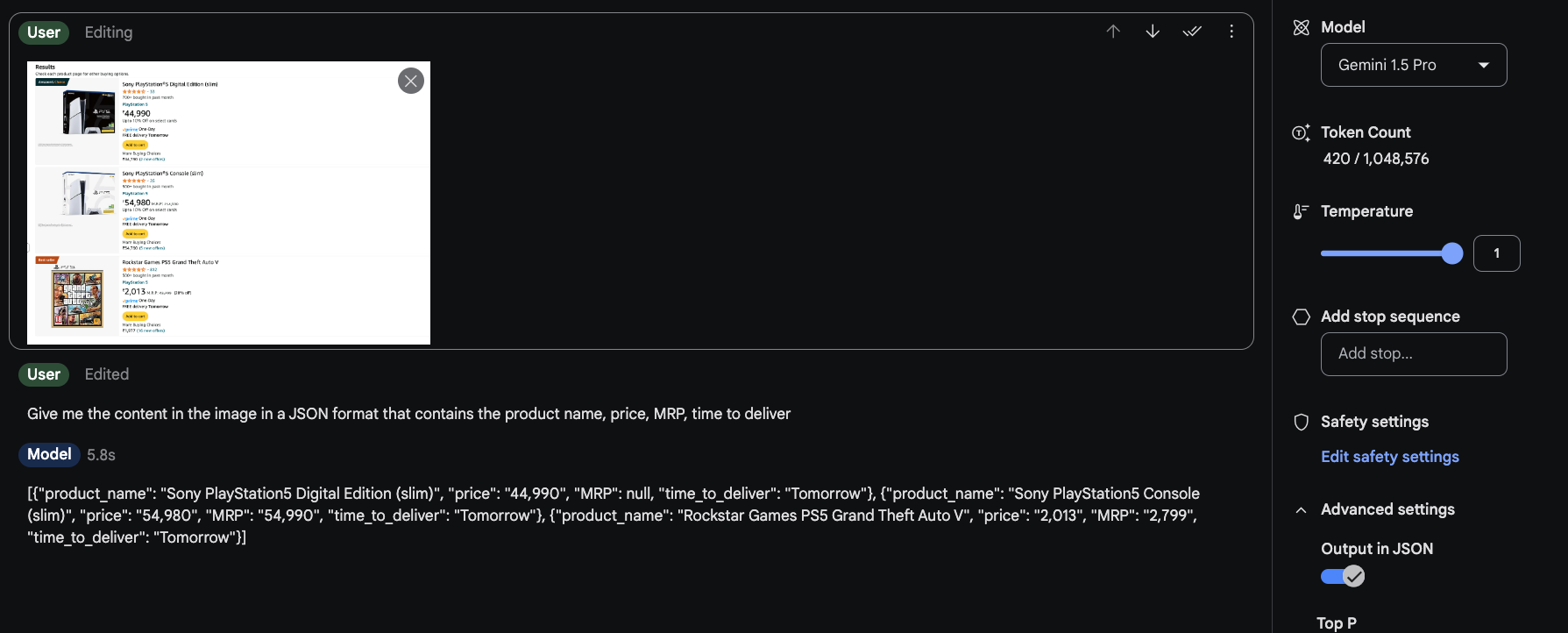

Multimodalność pozwala nam również wykorzystywać LLM jako substytuty innych wyspecjalizowanych usług. Na przykład. OCR lub Web Scraping.

Łatwe pobieranie danych ze stron internetowych i ich przekształcanie.

Prędkość

Gemini 1.5 Flash, jak sama nazwa wskazuje, został zaprojektowany tak, aby mieć przewagę nad innymi modelami pod względem czasu reakcji. We wspomnianym powyżej przykładzie skrobania stron internetowych różnica w czasie odpowiedzi wynosi około 2,5 sekundy, czyli prawie 40% szybciej, co sprawia, że Gemini 1.5 Flash jest lepszym wyborem do automatyzacji lub dowolnego przypadku użycia, który wymaga niższych opóźnień.

Kilka interesujących przypadków użycia Gemini 1.5 Flash

Podsumowanie materiałów wideo

Zrozumienie wideo Gemini 1.5 Pro jest najbardziej niedocenianą rzeczą w sztucznej inteligencji.

W ~50s “zobaczył” 11-minutowy film na Youtube (~175k tokenów) z najbardziej kultowymi momentami w sporcie i był w stanie idealnie (według mojej wiedzy) wymienić wszystkie 18 momentów. Nie ma drugiego tak dobrego wideo AI! pic.twitter.com/LaVGR3ATfU – Deedy (@deedydas) April 5, 2024

Pisanie kodu przy użyciu wideo

To jest oszałamiające 🤯

Dałem Gemini 1.5 Flash nagranie wideo, w którym robię zakupy, a on dał mi kod Selenium w ~ 5 sekund. To może zmienić tak wiele rzeczy. pic.twitter.com/Ojm6aueLe7 – Min Choi (@minchoi) 18 maja 2024 r.

Automatyzacja rozgrywki

Zbudowałem własnego asystenta omni przy użyciu Gemini 1.5 Flash, który poprowadził mnie przez Super Mario 64.

Gemini widzi, co robię na ekranie i komunikuje się ze mną w czasie rzeczywistym za pomocą głosu, a dzięki długiemu kontekstowi 1M ma pamięć wszystkiego, co robimy razem. Niesamowite. pic.twitter.com/doTngufjFL – Pietro Schirano (@skirano) May 21, 2024