La puissance de GPT-3.5 16K

Devriez-vous passer à la version payante de Cody ? Voici pourquoi.

Il y a quelques jours, nous avons publié un nouveau modèle pour tous nos utilisateurs payants juste après la publication de l’OpenAI : GPT-3.5 16k. Aussi intimidant que cela puisse paraître, cela pourrait changer la donne pour votre entreprise. Dans ce blog, nous allons nous pencher sur les cas d’utilisation du modèle GPT-3.5 16k, explorer ses avantages et mettre en évidence ses différences avec le modèle GPT-3.5 existant et le dernier modèle haut de gamme GPT-4.

Qu’est-ce que GPT-3.5 16K ?

Si vous avez déjà utilisé la version gratuite de Cody, vous êtes peut-être déjà familiarisé avec le modèle vanille GPT-3.5, qui utilise le modèle gpt-3.5-turbo d’OpenAI. Ce modèle est le choix le plus populaire pour de nombreux utilisateurs car il est abordable, rapide et fiable dans la plupart des cas. D’autre part, le GPT-3.5-16k utilise le modèle gpt-3.5-turbo-16k d’OpenAI, qui est une extension du modèle gpt-3.5-turbo. La différence significative réside dans l’aspect “16k”.

Qu’est-ce que 16K ?

Le suffixe “16K” indique que le modèle dispose d’une fenêtre contextuelle de 16 000 tokens, ce qui représente une augmentation significative par rapport aux 4 096 tokens existants. Dans notre blog précédent, nous avons expliqué en détail ce que sont les jetons. Une fenêtre contextuelle plus petite dans les modèles peut entraîner plusieurs limitations, notamment :

- Manque de pertinence : Avec une fenêtre contextuelle limitée, le modèle peut avoir du mal à saisir et à maintenir la pertinence du contexte plus large d’une conversation ou d’une tâche.

- Incapacité à maintenir le contexte : Une fenêtre contextuelle plus petite peut compliquer la tâche du modèle qui doit se souvenir des informations des parties précédentes de la conversation et y faire référence, ce qui entraîne des incohérences et des difficultés à maintenir un dialogue cohérent.

- Contraintes sur la longueur des requêtes : des fenêtres contextuelles plus courtes imposent des contraintes sur la longueur des requêtes, ce qui rend difficile la fourniture d’informations complètes ou la formulation de questions complexes.

- Limites du contexte de la base de connaissances : Une fenêtre contextuelle plus petite peut être confrontée à des limitations dans l’incorporation de connaissances provenant de documents pertinents en raison de la limite d’ingestion de données.

Avantages d’une fenêtre contextuelle plus grande

Une question pourrait surgir dans l’esprit de certaines personnes : comment GPT-3.5 peut-il traiter plus de 1000 pages web et documents sur Cody, alors que sa capacité n’est que de 4096 jetons ? Grâce aux progrès réalisés dans le domaine de l’IA générative, la fourniture d’un contexte ne signifie pas qu’il faille simplement alimenter des modèles linguistiques tels que GPT-3.5 Turbo avec l’ensemble du document tel quel. Les processus dorsaux tels que le découpage en morceaux, les enchâssements et les bases de données vectorielles sont utilisés pour prétraiter les données, maintenir la pertinence des morceaux et permettre au modèle de naviguer dans la fenêtre contextuelle prédéfinie.

Dans le scénario actuel, une fenêtre contextuelle plus large améliorerait les performances globales de l’IA en permettant des entrées plus importantes et plus complexes, tout en réduisant le nombre de transactions de stockage de vecteurs nécessaires pour générer une réponse. Étant donné que la fenêtre contextuelle englobe à la fois l’entrée et la sortie, une fenêtre plus large permettrait également au modèle de fournir des réponses élaborées et cohérentes tout en conservant le contexte de la conversation.

Une fenêtre contextuelle plus large permettrait également d’atténuer les hallucinations qui peuvent se produire lorsque la limite de jetons dans une conversation est dépassée.

GPT-3.5 Turbo 16K v/s GPT-4

Bien que gpt-3.5-turbo-16k soit la dernière version d’OpenAI, gpt-4 la surpasse encore sur plusieurs aspects tels que la compréhension du contexte visuel, l’amélioration de la créativité, la cohérence et les performances multilingues. Le seul domaine dans lequel GPT-3.5-16k excelle est la fenêtre contextuelle, car GPT-4 est actuellement disponible dans la variante 8k, la variante 32k étant encore en cours de déploiement progressif.

En attendant que la version 32k de gpt-4 soit largement accessible, le GPT-3.5-16k se distingue par sa fenêtre contextuelle plus large. Si vous recherchez un modèle offrant une fenêtre contextuelle plus large, le GPT-3.5-16k est le choix idéal.

Cas d’utilisation d’une fenêtre contextuelle plus grande

- Assistance à la clientèle : Une fenêtre contextuelle plus grande améliore la mémoire à court terme du modèle, ce qui le rend bien adapté aux applications impliquant l’assistance à la clientèle, le remplissage de formulaires et la collecte de données auprès des utilisateurs. Il permet au modèle de conserver le contexte sur une plus longue période, ce qui conduit à des réponses plus pertinentes aux entrées des utilisateurs telles que les noms, les identifiants des clients, les réclamations et les commentaires.

- Formation des employés : L’utilisation de Cody à des fins de formation des employés s’avère très efficace. La formation des salariés fait souvent appel à de nombreuses données relatives aux activités, aux étapes et aux processus de l’entreprise. Pour maintenir la pertinence contextuelle tout au long du programme de formation, il devient nécessaire d’intégrer l’ensemble de l’historique des conversations du stagiaire. Une fenêtre contextuelle plus large permet d’inclure davantage d’informations historiques, ce qui facilite une expérience de formation plus complète et plus efficace.

- Analyse des données : Les tâches impliquant l’analyse financière et l’inférence statistique nécessitent souvent le traitement de grands volumes de données afin d’en tirer des informations significatives. Avec une fenêtre contextuelle plus grande, le modèle peut retenir plus d’informations pertinentes pendant le calcul, ce qui permet une analyse plus cohérente et plus précise. Par exemple, la comparaison des bilans et des performances globales d’une entreprise d’une année sur l’autre peut être réalisée plus efficacement avec une fenêtre contextuelle plus grande.

Comparaison entre GPT-3.5 4K et 16K

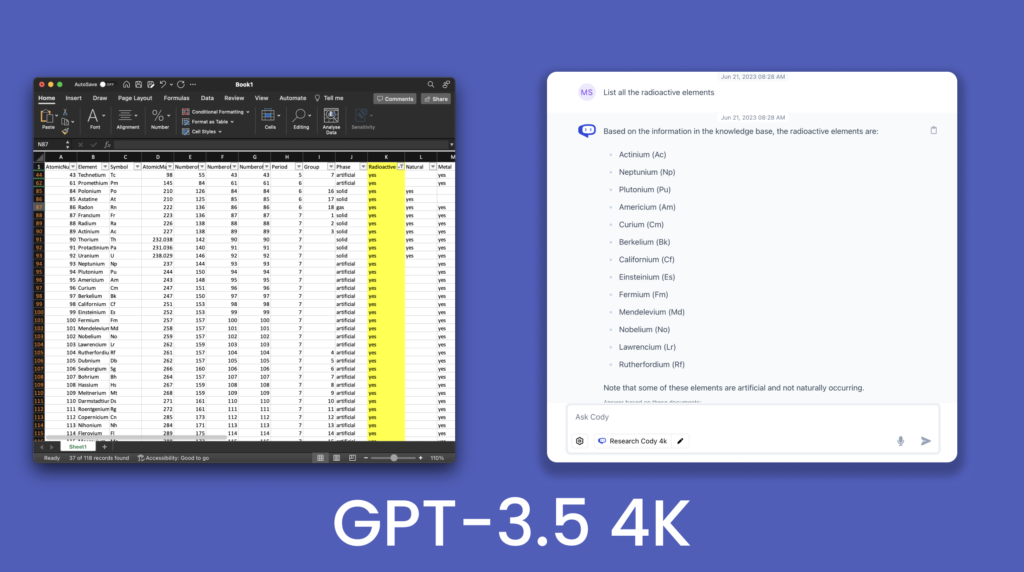

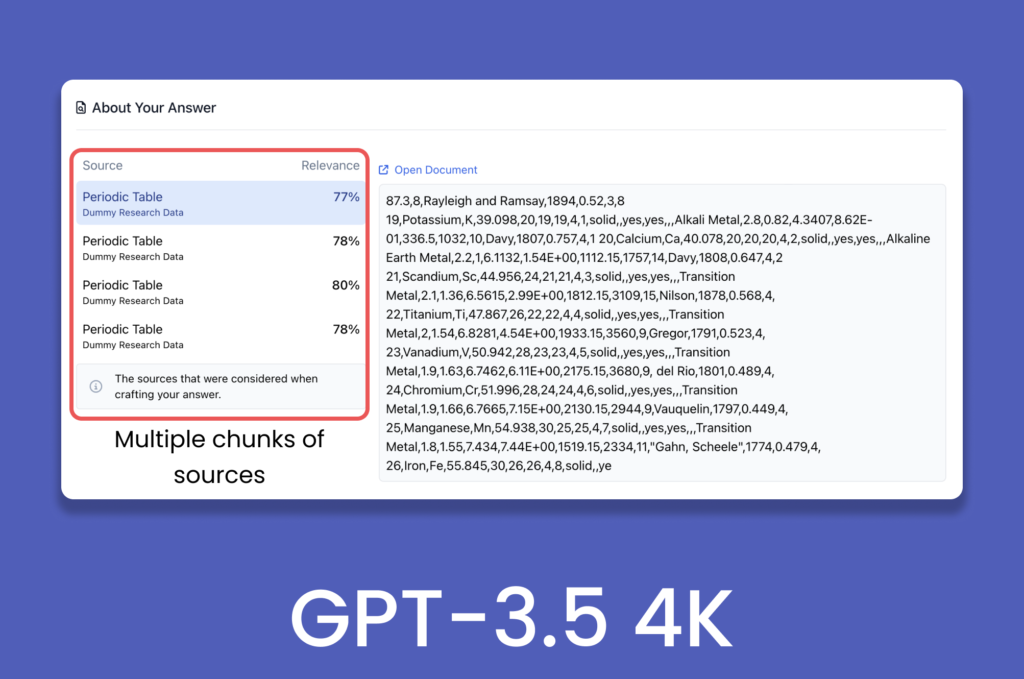

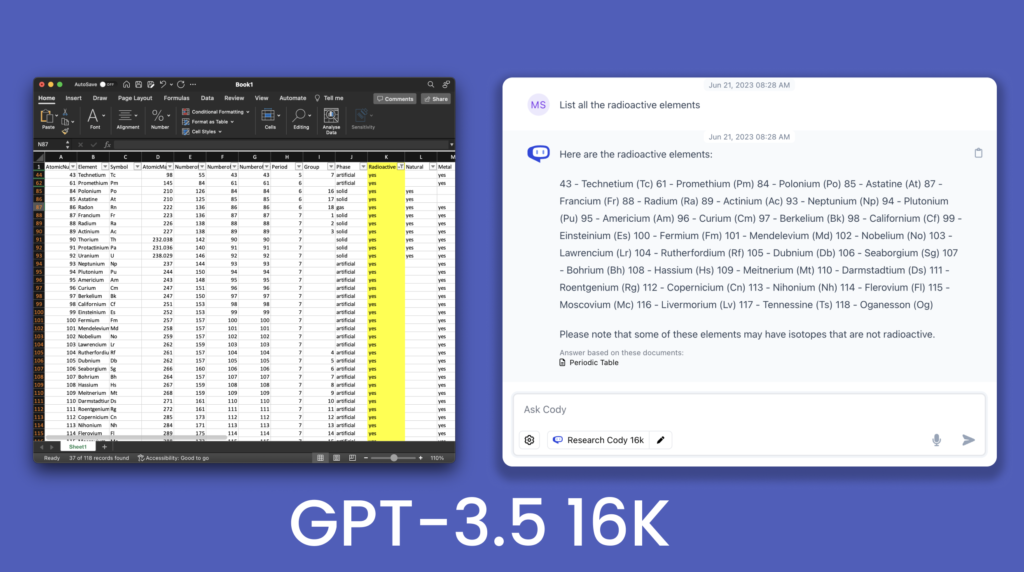

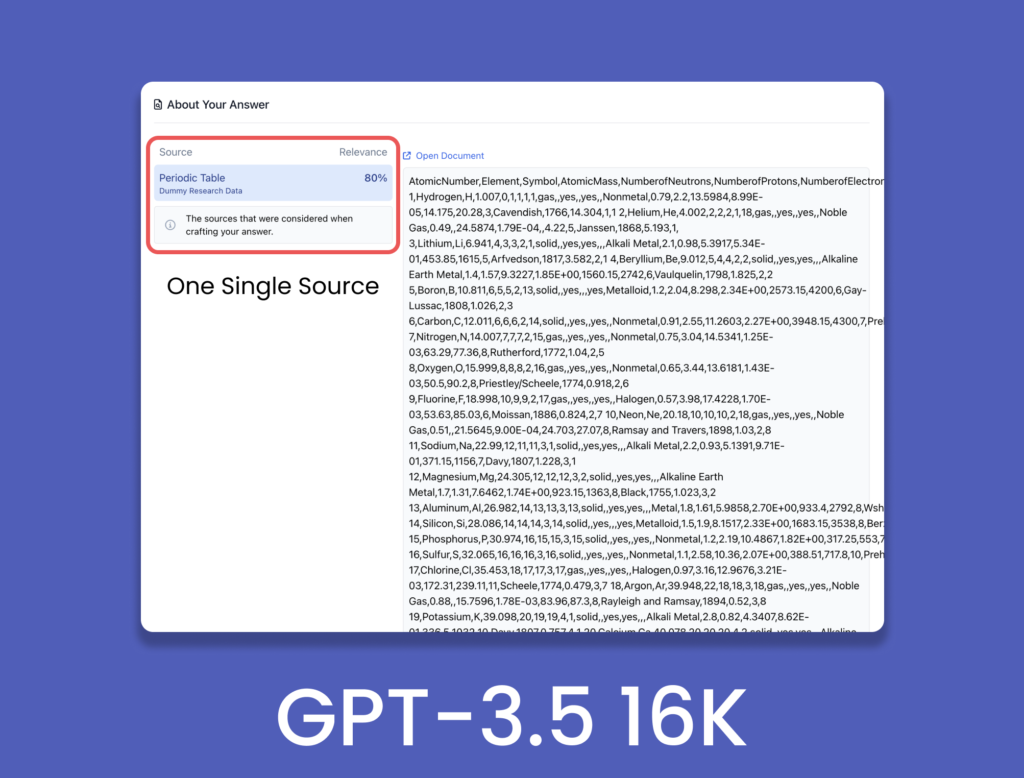

Pour démontrer les améliorations apportées au modèle 16K, nous avons interrogé un fichier .csv du tableau périodique contenant 118 éléments et leurs caractéristiques.

La comparaison montre que le GPT-3.5 4K n’a pas été en mesure de produire tous les éléments radioactifs dans sa réponse et qu’il a omis certains éléments. En revanche, le GPT-3.5 16K a produit presque tous les éléments radioactifs présents dans le tableau fourni. Cela démontre l’amélioration de l’élaboration des réponses grâce à l’élargissement de la fenêtre contextuelle. Ce n’était qu’un petit aperçu du potentiel de la fenêtre contextuelle de 16k, avec une infinité d’applications et d’implémentations. Avec le GPT-4 32K dans le pipeline, le modèle 16K peut faciliter une transition en douceur vers une fenêtre contextuelle plus grande.

Faut-il procéder à une mise à niveau ?

L’agrandissement de la fenêtre contextuelle est sans aucun doute une mise à jour importante et non un simple gadget. Une meilleure compréhension du contexte joue un rôle crucial dans l’amélioration de la qualité des réponses, et une fenêtre contextuelle plus large libère un potentiel substantiel pour ces modèles de langue (LLM). En permettant une meilleure compréhension de l’historique de la conversation et des indices contextuels, les LLM peuvent fournir des résultats plus précis et plus adaptés au contexte.

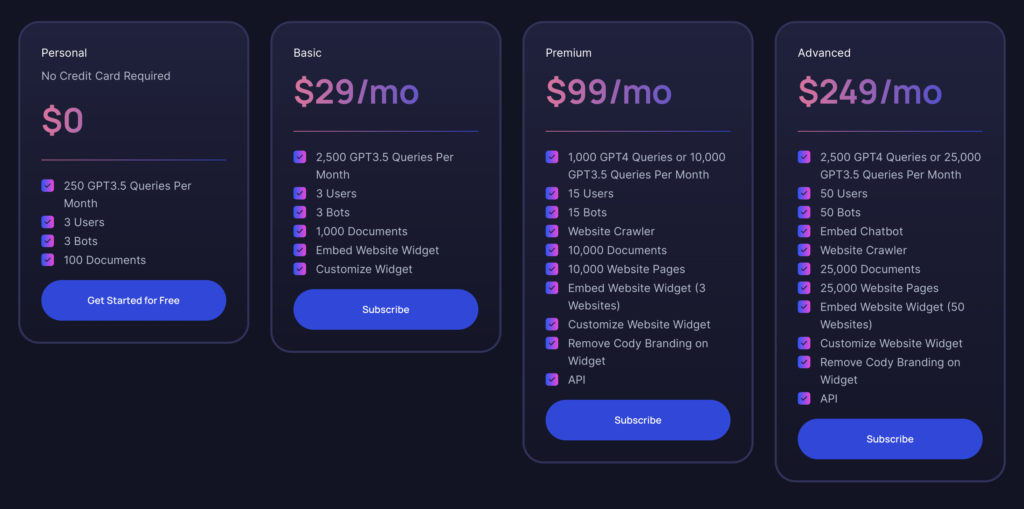

Comme indiqué précédemment, la variante 16K de GPT-3.5 est disponible pour tous les utilisateurs à partir du plan de base. Si vous utilisez le plan personnel (gratuit) depuis un certain temps, vous avez déjà expérimenté les possibilités offertes par Cody. Le plan de base offre un excellent rapport qualité-prix, en particulier si vous n’avez pas besoin des fonctionnalités supplémentaires de GPT-4. Il convient aux personnes qui construisent un robot dans le cadre d’un projet ou d’un prototype pour leur entreprise, avec le choix supplémentaire du modèle GPT-3.5 16K. À l’avenir, lorsque nous lancerons la variante GPT-4 32K, vous pourrez toujours passer au plan premium si vous avez besoin de plus de jetons.

Pour les grandes entreprises, le plan avancé est l’option la plus puissante, qui répond aux besoins d’utilisation intensive des ressources et des volumes importants. Il offre des capacités complètes pour répondre aux exigences des opérations à grande échelle.