LLaMA 2 : Le modèle d’IA Open Source de Meta

Le tout nouveau LLM en ville vaut-il la peine d’être annoncé ?

Il y a quelques jours, Meta a publié sa dernière version de LLM, appelée Llama 2, en collaboration avec Microsoft. Si vous avez suivi le battage médiatique autour du LLM, vous en avez peut-être déjà entendu parler ou même lu des informations sur ses nouvelles fonctionnalités. Pour simplifier les choses, nous allons énumérer quatre raisons pour lesquelles le projet Llama 2 suscite un tel engouement et comment il se compare à certains des meilleurs programmes d’éducation et de formation tout au long de la vie.

Gratuit pour la recherche et l’utilisation commerciale

L’une des raisons majeures de l’intérêt suscité par le Llama 2 est que Meta a rendu l’ensemble du modèle gratuit pour presque tout le monde, à l’exception de certaines grandes entreprises qui peuvent être soumises à certaines conditions. Cette décision ouvre des perspectives intéressantes pour les personnes qui envisagent de créer leur propre entreprise ou de s’aventurer dans le monde de l’IA générative. C’est le moment idéal pour plonger dans les eaux de l’IA, d’autant plus qu’un modèle linguistique de ce calibre est librement accessible. Bien qu’il existe déjà de nombreux modèles à code source ouvert, aucun d’entre eux ne provenait d’une entreprise de la stature de Meta et ne pouvait servir de concurrent direct à GPT.

“Il y a eu des publications publiques de LLM pré-entraînés (tels que BLOOM (Scao et al., 2022), LLaMa-1 (Touvron et al., 2023), et Falcon (Penedo et al., 2023)) qui correspondent à la performance des concurrents pré-entraînés fermés tels que GPT-3 (Brown et al…, 2020) et Chinchilla (Hoffmann et al., 2022), mais aucun de ces modèles n’est un substitut approprié aux LLM fermés “produits”, tels que ChatGPT, BARD et Claude.” – Document de recherche Meta

Sécurité

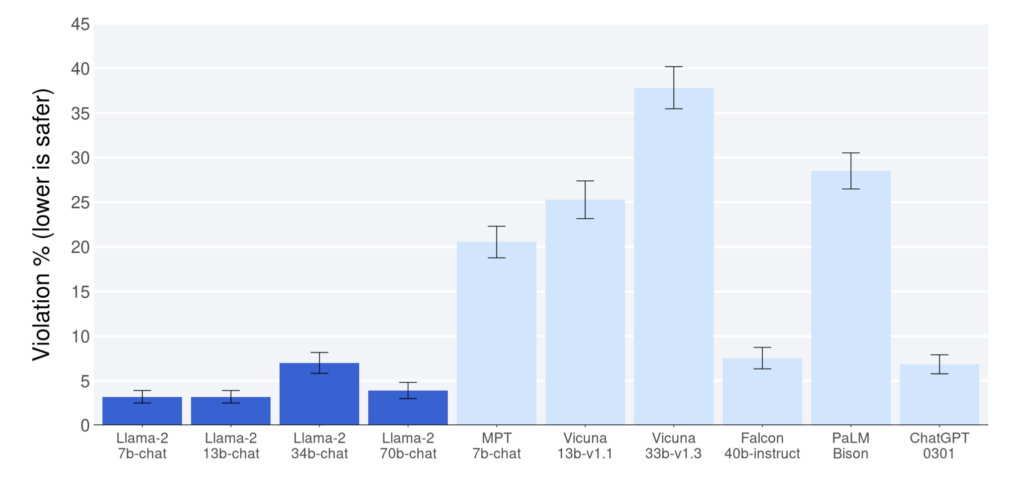

D’après les rapports publiés dans le document de recherche Meta, le Llama 2 a démontré des performances supérieures à celles d’autres modèles open-source dans les domaines de l’utilité et de la sécurité. Il a même surpassé ChatGPT (modèles 7b, 13b, 70b) sur ces aspects. Cependant, il est important de noter que le document de recherche reconnaît la possibilité de données biaisées en faveur du lama 2, ce qui devrait être pris en considération lors de l’interprétation des résultats. Néanmoins, même si Llama 2 se rapproche du benchmark ChatGPT, il mérite d’être félicité.

L’un des facteurs les plus importants contribuant à la sécurité de Llama 2 est la confidentialité des données. Contrairement à certains modèles, le Llama 2 ne nécessite pas l’envoi de vos données à un serveur externe, tel qu’OpenAI, pour obtenir des réponses. Cet attribut unique rend le modèle particulièrement précieux pour les cas d’utilisation critiques et sensibles, car il permet de protéger les données des utilisateurs et de préserver leur vie privée. Les utilisateurs peuvent exécuter le modèle sur des serveurs privés, leurs données étant confinées dans leur infrastructure.

Source ouverte

Les LLM les plus populaires actuellement utilisés fonctionnent comme des boîtes noires, les utilisateurs n’ayant qu’un aperçu limité de leur fonctionnement. En revanche, les modèles à source ouverte offrent une approche transparente, permettant aux utilisateurs de comprendre leur fonctionnement interne. Cette transparence inspire confiance et assurance lors de l’utilisation de ces modèles, malgré les difficultés qu’ils peuvent rencontrer, comme la production de spam ou de désinformation.

En outre, la nature open-source de ces modèles encourage les efforts de collaboration, ce qui permet une amélioration et un développement continus dans le domaine des LLM. Par conséquent, les modèles à source ouverte jouent un rôle crucial dans les progrès réalisés dans le domaine des modèles de langage.

“Et nous pensons que c’est plus sûr. Ouvrir l’accès aux modèles d’IA actuels signifie qu’une génération de développeurs et de chercheurs peut les tester sous contrainte, identifier et résoudre les problèmes rapidement, en tant que communauté. En voyant comment ces outils sont utilisés par d’autres, nos propres équipes peuvent en tirer des enseignements, améliorer ces outils et corriger les vulnérabilités.” – Site web de Meta

Bien que Llama 2 fasse l’objet d’une licence ouverte, Meta n’a toujours pas divulgué les données sur lesquelles il a été formé, ce qui pose problème en termes de confidentialité des données des utilisateurs de Meta. Meta affirme avoir “fait un effort pour supprimer les données de certains sites connus pour contenir un volume important d’informations personnelles sur des particuliers” dans le document de recherche Llama 2, mais n’a pas indiqué quels étaient ces sites.

Performance

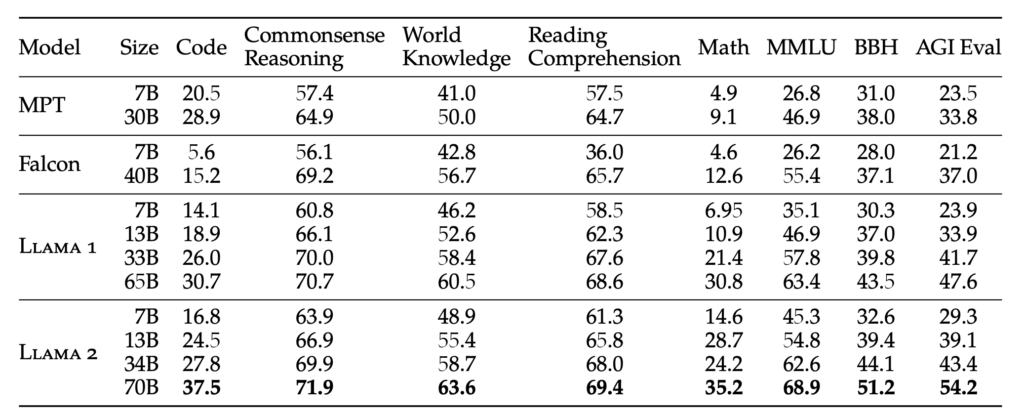

Llama 2 est disponible en quatre poids différents : 7B, 13B, 34B et 70B. Le poids représente le nombre de paramètres sur lesquels le modèle est entraîné. En général, des paramètres plus importants permettent d’obtenir des réponses plus précises et plus fiables, mais ils nécessitent également des ressources informatiques plus importantes. Pour améliorer les caractéristiques humaines du modèle, le lama 2 subit un réglage fin à l’aide d’instructions et de la méthode RLHF (Reinforcement Learning with Human Feedback), également utilisée par GPT.

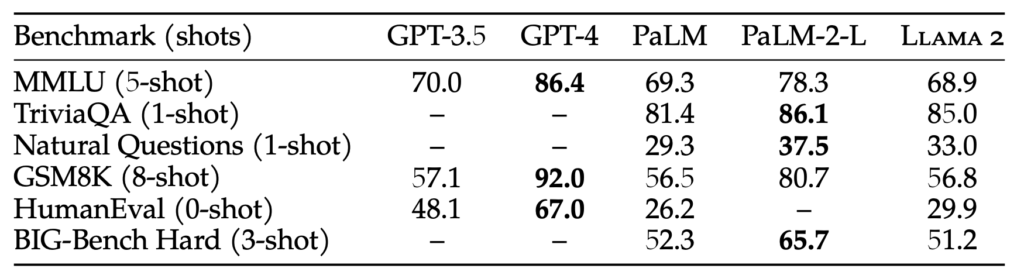

Bien que la taille des paramètres de 70 milliards soit importante, elle reste insuffisante par rapport à GPT-3.5, dont la taille des paramètres est de 175 milliards. Par conséquent, les performances de Llama 2 n’atteindront peut-être pas celles de GPT-3.5, mais les tests de référence indiquent qu’elles sont proches de celles de GPT-3.5, même si la taille des paramètres est plus petite. Malgré cette différence, Llama 2 surpasse tous les modèles open-source actuellement disponibles.

“Le RLHF est une procédure de formation de modèle qui est appliquée à un modèle linguistique affiné afin d’aligner davantage la langue de l’utilisateur. Le comportement du modèle avec les préférences humaines et le suivi des instructions. Nous collectons des données qui représentent des préférences humaines échantillonnées de manière empirique, par lesquelles les annotateurs humains choisissent, parmi deux sorties de modèle, celle qu’ils préfèrent. Ce feedback humain est ensuite utilisé pour former un modèle de récompense, qui apprend des modèles dans les préférences des annotateurs humains et peut ensuite automatiser les décisions de préférence.” – Document de recherche Meta

Conclusion

Il existe en effet une multitude de modèles open-source qui émergent, et avec la sortie de Llama 2, les possibilités semblent illimitées. Bien qu’il faille un certain temps pour que ces modèles open-source puissent rivaliser directement avec quelque chose d’aussi avancé que GPT-4, l’excitation réside dans l’obtention d’un modèle qui se rapproche des capacités de GPT-3.5. Ce progrès est en soi tout à fait remarquable.

À l’avenir, alors que la formation LLM devient plus efficace, la possibilité d’avoir un ChatGPT personnalisé, affiné avec vos données sur votre appareil local, devient une perspective alléchante. Une plateforme qui offre de telles capacités est Cody, un assistant intelligent d’IA conçu pour soutenir les entreprises dans divers aspects. Tout comme ChatGPT, Cody peut être formé sur les données de votre entreprise, votre équipe, vos processus et vos clients, en utilisant votre base de connaissances unique.

Avec Cody, les entreprises peuvent exploiter la puissance de l’IA pour créer un assistant personnalisé et intelligent qui répond spécifiquement à leurs besoins, ce qui en fait un ajout prometteur au monde des solutions professionnelles basées sur l’IA.

Cliquez ici pour lire le document de métarecherche sur le lama 2. Essayez Llama 2 ici.