Gemini 1.5 Flash gegen GPT-4o: Googles Antwort auf GPT-4o?

Der Wettlauf um die KI hat sich verschärft und ist zu einem Aufholspiel zwischen den großen Playern der Technologiebranche geworden. Die Einführung von GPT-4o kurz vor der Google I/O ist kein Zufall. Die unglaublichen Fähigkeiten von GPT-4o im Bereich der Multimodalität, genauer gesagt der Omnimodalität, haben im Wettbewerb der Generativen KI für Aufsehen gesorgt. Aber Google ist nicht jemand, der sich zurückhält. Während der Google I/O wurden neue Varianten der Modelle Gemini und Gemma angekündigt. Unter allen angekündigten Modellen sticht das Gemini 1.5 Flash als das wirkungsvollste hervor. In diesem Blog werden wir die wichtigsten Funktionen des Gemini 1.5 Flash untersuchen und ihn mit dem Gemini 1.5 Pro und dem Gemini 1.5 Flash vs. GPT-4o vergleichen, um festzustellen, welches Gerät besser ist.

Vergleich von Gemini 1.5 Flash mit GPT-4o

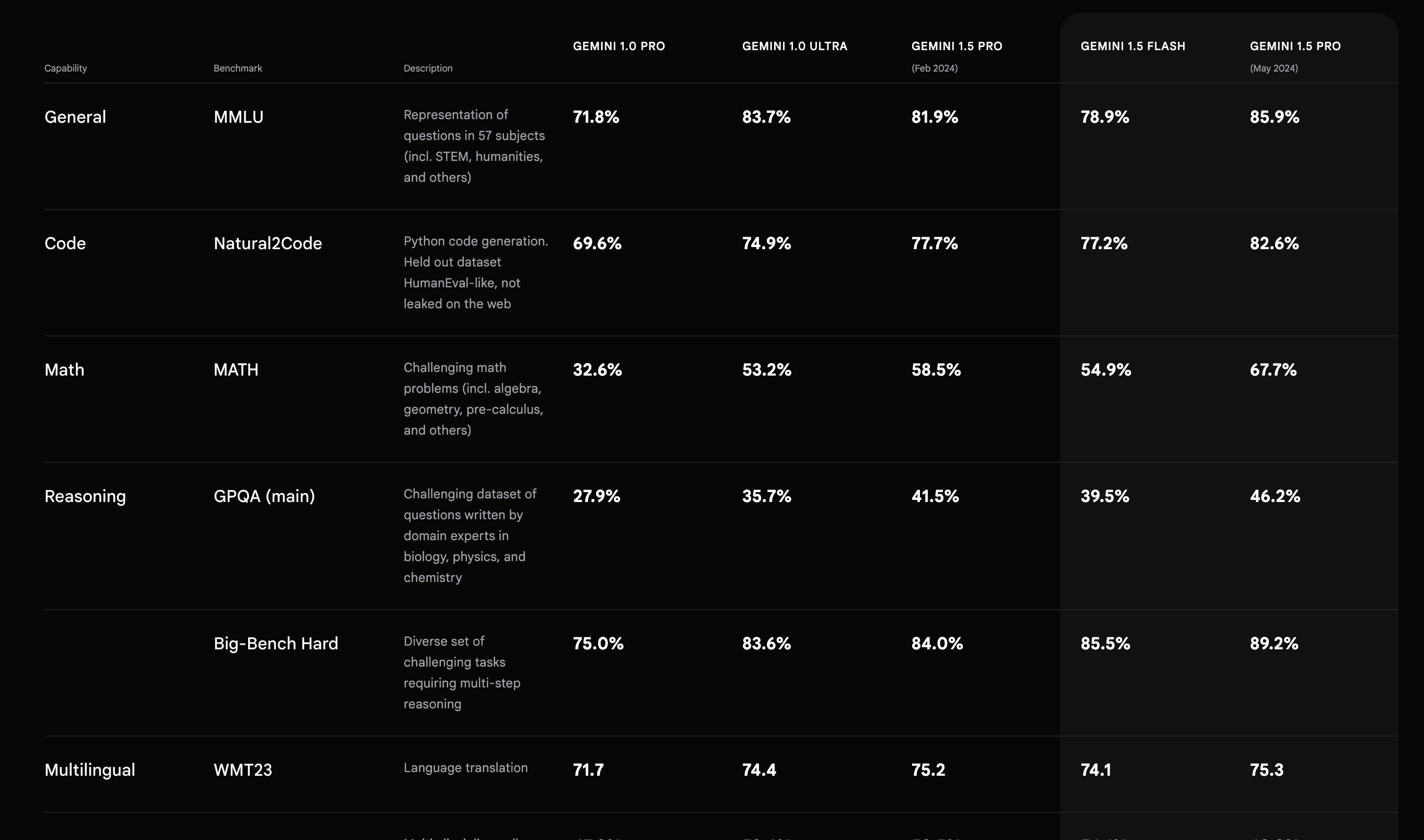

Basierend auf den von Google veröffentlichten Benchmark-Ergebnissen hat das Gemini 1.5 Flash im Vergleich zu allen anderen LLMs von Google eine überlegene Leistung bei Audio und liegt bei anderen Benchmarks gleichauf mit dem auslaufenden Modell Gemini 1.5 Pro (Feb 2024). Obwohl wir nicht empfehlen würden, sich bei der Bewertung der Leistung eines LLM vollständig auf Benchmarks zu verlassen, helfen sie bei der Quantifizierung von Leistungsunterschieden und kleineren Upgrades.

Kontext-Fenster

Genau wie der Gemini 1.5 Pro verfügt der Flash über ein Kontextfenster von 1 Million Token. Das ist mehr als bei allen OpenAI-Modellen und eines der größten Kontextfenster für produktionsreife LLMs. Ein größeres Kontextfenster ermöglicht ein besseres Verständnis der Daten und kann Techniken von Drittanbietern wie RAG (Retrieval-Augmented Generation) für Anwendungsfälle mit einer großen Wissensbasis verbessern, indem die Chunk-Größe erhöht wird. Außerdem ermöglicht ein größeres Kontextfenster die Erstellung von mehr Text, was in Szenarien wie dem Schreiben von Artikeln, E-Mails und Pressemitteilungen hilfreich ist.

Multimodalität

Gemini-1.5 Flash ist multimodal. Multimodalität ermöglicht die Eingabe von Kontext in Form von Audio, Video, Dokumenten usw. LLMs mit Multimodalität sind vielseitiger und öffnen die Türen für mehr Anwendungen der generativen KI, ohne dass eine Vorverarbeitung erforderlich ist.

“Gemini 1.5 Modelle sind für die Verarbeitung extrem langer Kontexte ausgelegt. Sie sind in der Lage, feinkörnige Informationen aus bis zu 10 Millionen Token abzurufen und zu verarbeiten. Dieser Umfang ist unter den heutigen großen Sprachmodellen (LLMs) beispiellos und ermöglicht die Verarbeitung langer, gemischtmodaler Eingaben, einschließlich ganzer Dokumentensammlungen, mehrstündiger Videos und fast fünf Tage langer Audiodateien.” – DeepMind Bericht

Dabbas = Zugwaggon auf Hindi. Demonstration der Multimodalität und mehrsprachigen Leistung.

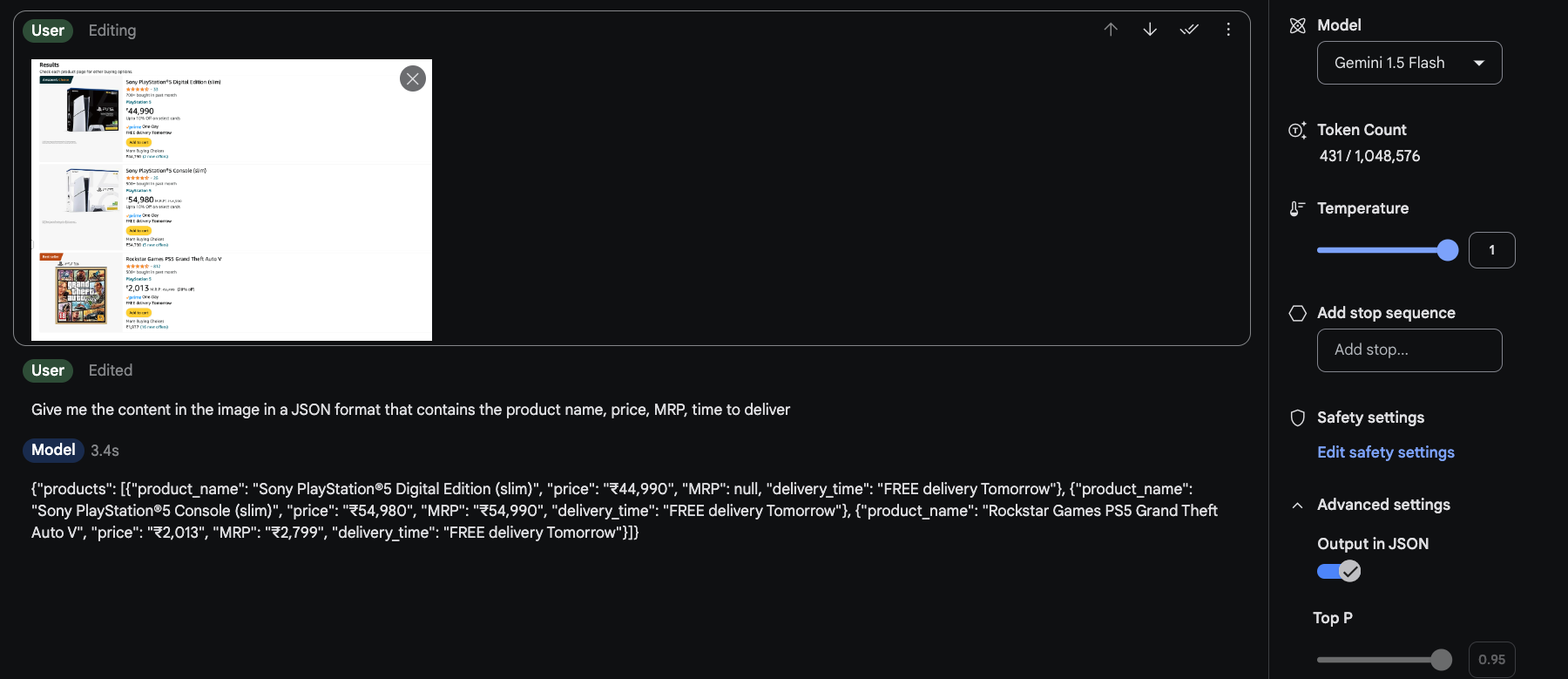

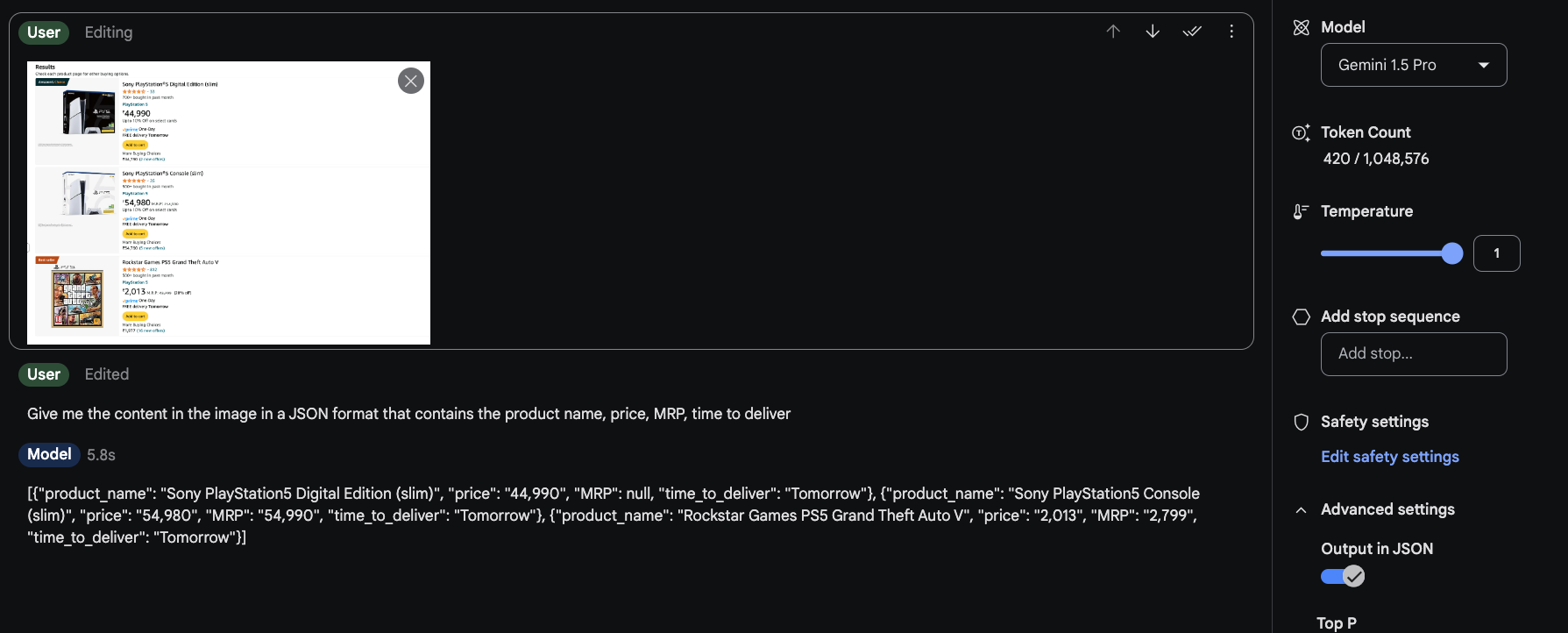

Die Multimodalität ermöglicht es uns auch, LLMs als Ersatz für andere spezialisierte Dienstleistungen zu nutzen. Zum Beispiel. OCR oder Web Scraping.

Scrapen Sie ganz einfach Daten von Webseiten und wandeln Sie sie um.

Geschwindigkeit

Gemini 1.5 Flash ist, wie der Name schon sagt, darauf ausgelegt, anderen Modellen in Bezug auf die Reaktionszeit überlegen zu sein. Bei dem oben erwähnten Beispiel des Web-Scraping beträgt der Unterschied in der Reaktionszeit ca. 2,5 Sekunden, was fast 40 % schneller ist. Damit ist der Gemini 1.5 Flash die bessere Wahl für den Einsatz in der Automatisierung oder für alle Anwendungsfälle, die eine geringere Latenz erfordern.

Einige interessante Anwendungsfälle von Gemini 1.5 Flash

Videos zusammenfassen

Das Videoverständnis von Gemini 1.5 Pro ist das am meisten unterschätzte in der KI.

In den ~50er Jahren “sah” es ein 11minütiges Youtube-Video (~175k Token) mit den ikonischsten Momenten des Sports und konnte (meines Wissens) alle 18 Momente perfekt auflisten. Es gibt keine andere Video-KI, die so gut ist! pic.twitter.com/LaVGR3ATfU – Deedy (@deedydas) April 5, 2024

Code schreiben mit Video

Das ist umwerfend 🤯.

Ich habe Gemini 1.5 Flash-Videoaufnahmen von mir beim Einkaufen gegeben und es hat mir in ~5 Sekunden Selenium-Code geliefert. Das kann so viele Dinge verändern. pic.twitter.com/Ojm6aueLe7 – Min Choi (@minchoi) May 18, 2024

Spielablauf automatisieren

Ich habe meinen eigenen Omni-Assistenten mit Gemini 1.5 Flash gebaut, um mich durch Super Mario 64 zu führen.

Gemini kann sehen, was ich auf meinem Bildschirm tue, und mit mir in Echtzeit über die Stimme kommunizieren. Und dank des langen 1M-Kontextes hat er ein Gedächtnis für alles, was wir gemeinsam tun. Unglaublich. pic.twitter.com/doTngufjFL – Pietro Schirano (@skirano) May 21, 2024