LLaMA 2: نموذج الذكاء الاصطناعي مفتوح المصدر من Meta

هل أحدث ماجستير في القانون في المدينة يستحق كل هذا الضجيج؟

قبل يومين ، أصدرت Meta أحدث إصدار لها من LLM يسمى Llama 2 بالتعاون مع Microsoft. إذا كنت تتابع ضجيج LLM ، فربما تكون قد سمعت عنه بالفعل أو حتى قرأت عن ميزاته الجديدة. لتبسيط الأمور ، سنقوم بإدراج أربعة أسباب تجعل Llama 2 يولد الكثير من الضجيج وكيف يقارن ببعض أفضل LLMs.

مجاني للبحث والاستخدام التجاري

أحد الأسباب المهمة التي جذبت اهتمام الناس ب Llama 2 هو أن Meta جعلت النموذج بأكمله مجانيا للجميع تقريبا ، باستثناء بعض الشركات الكبيرة التي قد يكون لها شروط معينة. تفتح هذه الخطوة فرصا مثيرة للأفراد الذين يفكرون في بدء أعمالهم التجارية الخاصة أو المغامرة في عالم الذكاء الاصطناعي التوليدية. الآن هو الوقت المثالي للغوص في مياه الذكاء الاصطناعي ، خاصة مع نموذج لغة من هذا العيار يمكن الوصول إليه مجانا. على الرغم من وجود العديد من النماذج مفتوحة المصدر المتاحة بالفعل ، إلا أن أيا منها لم يأت من شركة بمكانة Meta ويمكن أن يكون بمثابة منافسين مباشرين ل GPT.

“كانت هناك إصدارات عامة من LLMs المدربة مسبقا (مثل BLOOM (Scao et al. ، 2022) ، LLaMa-1 (Touvron et al. ، 2023) ، و Falcon (Penedo et al. ، 2023)) التي تتطابق مع أداء المنافسين المدربين مسبقا المغلقين مثل GPT-3 (Brown et al. ، 2020) و Chinchilla (Hoffmann et al. ، 2022) ، ولكن لا يعد أي من هذه النماذج بدائل مناسبة ل LLMs “المنتج” المغلقة ، مثل ChatGPT و BARD و Claude.” – ورقة بحث ميتا

أمان

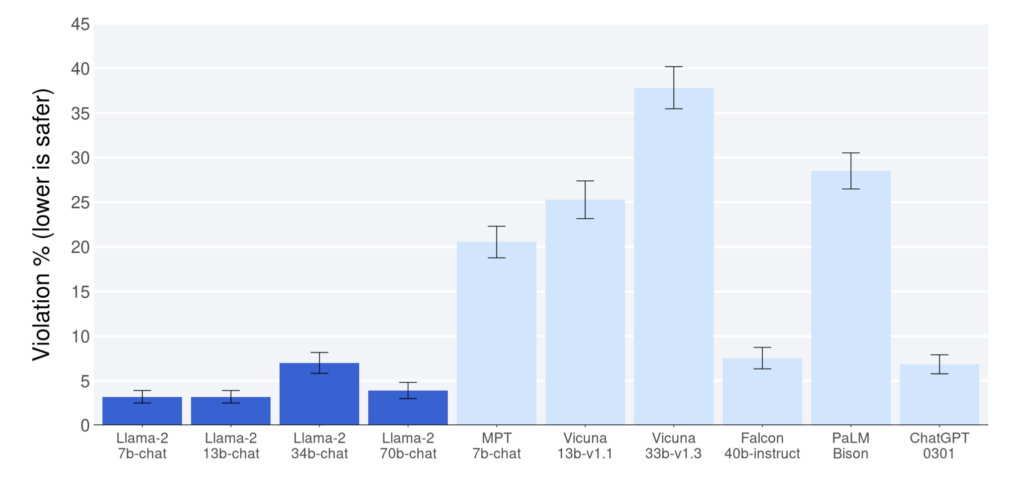

استنادا إلى التقارير المنشورة في ورقة بحث Meta ، أظهر Llama 2 أداء فائقا مقارنة بالنماذج الأخرى مفتوحة المصدر في معيار المساعدة والسلامة. حتى أنها تفوقت على ChatGPT (نماذج 7b و 13b و 70b) في هذه الجوانب. ومع ذلك ، من المهم ملاحظة أن الورقة البحثية تقر بإمكانية وجود بيانات متحيزة لصالح اللاما 2 ، والتي يجب أخذها في الاعتبار أثناء تفسير النتائج. ومع ذلك ، حتى لو اقترب Llama 2 من معيار ChatGPT ، فإنه يستحق الثناء.

أحد أهم العوامل التي تساهم في سلامة Llama 2 هو خصوصية بياناته. على عكس بعض الطرز ، لا يتطلب Llama 2 إرسال بياناتك إلى خادم خارجي ، مثل OpenAI ، لجلب الردود. هذه السمة الفريدة تجعل النموذج ذا قيمة خاصة لحالات الاستخدام الحرجة والحساسة ، لأنه يساعد في حماية بيانات المستخدمين والحفاظ على خصوصيتهم. يمكن للمستخدمين تشغيل النموذج على خوادم خاصة مع احتواء بياناتهم داخل بنيتهم التحتية.

المصدر المفتوح

تعمل LLMs الأكثر شيوعا المستخدمة حاليا كصناديق سوداء ، حيث يكون لدى المستخدمين رؤية محدودة لأدائها. في المقابل ، توفر النماذج مفتوحة المصدر نهجا شفافا ، مما يسمح للمستخدمين بفهم أعمالهم الداخلية. تغرس هذه الشفافية الثقة والطمأنينة عند استخدام مثل هذه النماذج، على الرغم من التحديات التي قد تواجهها، مثل توليد الرسائل غير المرغوب فيها أو المعلومات المضللة.

بالإضافة إلى ذلك ، تشجع الطبيعة مفتوحة المصدر لهذه النماذج الجهود التعاونية ، مما يؤدي إلى التحسين والتطوير المستمر في مجال LLMs. نتيجة لذلك ، تلعب النماذج مفتوحة المصدر دورا حاسما في دفع التقدم في عالم نماذج اللغة.

“ونعتقد أنه أكثر أمانا. إن فتح الوصول إلى نماذج الذكاء الاصطناعي اليوم يعني أن جيلا من المطورين والباحثين يمكنهم اختبار اختبارها وتحديد المشكلات وحلها بسرعة كمجتمع. من خلال رؤية كيفية استخدام الآخرين لهذه الأدوات ، يمكن لفرقنا التعلم منها وتحسين هذه الأدوات وإصلاح نقاط الضعف.” — موقع ميتا

على الرغم من أن Llama 2 مرخص بشكل مفتوح ، إلا أن Meta لم تكشف بعد عن البيانات التي تم تدريبها عليها ، والتي لا تزال بارزة من حيث خصوصية البيانات لمستخدمي Meta. تقول Meta إنها “بذلت جهدا لإزالة البيانات من مواقع معينة معروفة باحتوائها على كمية كبيرة من المعلومات الشخصية عن الأفراد” في ورقة بحث Llama 2 ، لكنها لم تدرج ماهية هذه المواقع.

اداء

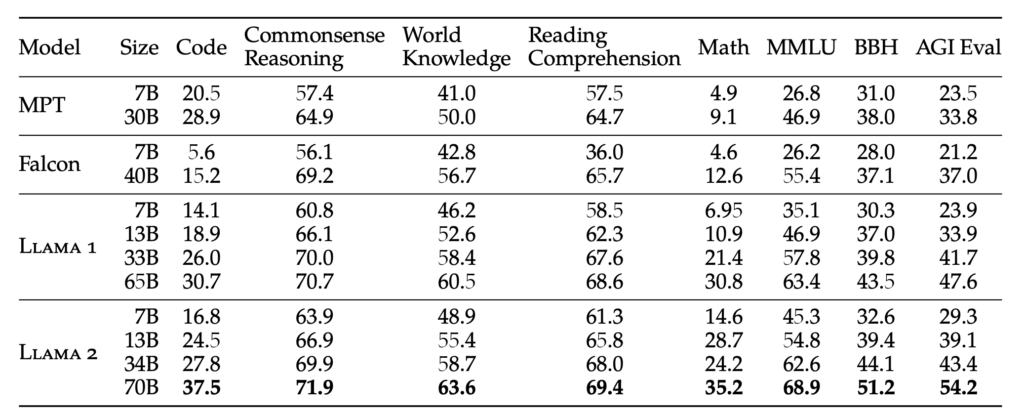

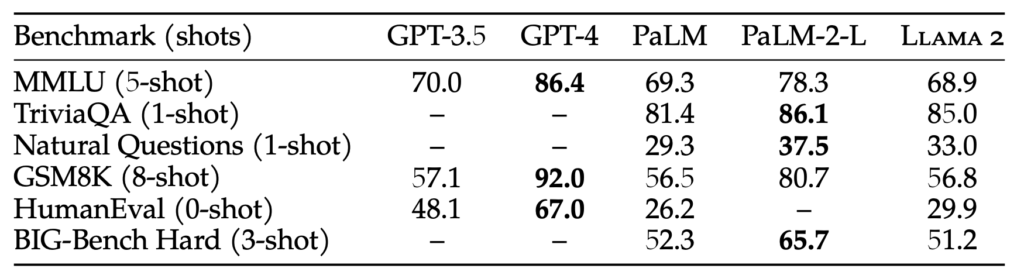

اللاما 2 متوفر بأربعة أوزان مختلفة: 7B و 13B و 34B و 70B. يمثل الوزن عدد المعلمات التي يتم تدريب النموذج عليها. بشكل عام ، تؤدي أحجام المعلمات الأكبر إلى استجابات أكثر دقة وموثوقية ، ولكنها تتطلب أيضا موارد حسابية أكبر. لتحسين الخصائص الشبيهة بالإنسان للنموذج ، يخضع Llama 2 للضبط الدقيق باستخدام ضبط التعليمات وطريقة RLHF (التعلم المعزز مع التغذية الراجعة البشرية) التي تستخدمها GPT أيضا.

في حين أن حجم المعلمة 70B كبير ، إلا أنه لا يزال أقل مقارنة ب GPT-3.5 ، الذي يحتوي على حجم معلمة 175B. نتيجة لذلك ، قد لا يتطابق أداء Llama 2 مع أداء GPT-3.5 ، لكن الاختبارات المعيارية تشير إلى منافسة وثيقة حتى مع حجم معلمتها الأصغر. على الرغم من هذا الاختلاف ، يتفوق Llama 2 على جميع النماذج مفتوحة المصدر الحالية المتاحة حاليا.

“RLHF هو إجراء تدريب نموذجي يتم تطبيقه على نموذج لغة مضبوط بدقة لمزيد من المواءمة نموذج السلوك مع التفضيلات البشرية والتعليمات التالية. نقوم بجمع البيانات التي تمثل التفضيلات البشرية التي تم أخذ عينات منها تجريبيا ، حيث يختار المعلقون البشريون أي من مخرجات النموذج التي يفضلونها. يتم استخدام هذه التعليقات البشرية لاحقا لتدريب نموذج المكافأة ، الذي يتعلم الأنماط في تفضيلات المعلقين البشريين ويمكنه بعد ذلك أتمتة قرارات التفضيل.” – ورقة بحث ميتا

استنتاج

هناك بالفعل العديد من النماذج مفتوحة المصدر الناشئة ، ومع إصدار Llama 2 ، تبدو الاحتمالات بلا حدود. في حين أن الأمر قد يستغرق بعض الوقت حتى تتنافس هذه النماذج مفتوحة المصدر بشكل مباشر مع شيء متقدم مثل GPT-4 ، إلا أن الإثارة تكمن في الحصول على نموذج يقترب من قدرات GPT-3.5. وهذا التقدم في حد ذاته رائع حقا.

بالنظر إلى المستقبل ، نظرا لأن تدريب LLM أصبح أكثر كفاءة ، فإن إمكانية الحصول على ChatGPT مخصص ، مضبوط بدقة مع بياناتك على جهازك المحلي ، يصبح احتمالا محيرا. إحدى المنصات التي توفر مثل هذه القدرات هي Cody ، وهو مساعد الذكاء الاصطناعي ذكي مصمم خصيصا لدعم الشركات في مختلف الجوانب. مثل ChatGPT ، يمكن تدريب Cody على بيانات عملك وفريقك وعملياتك وعملائك ، باستخدام قاعدة المعرفة الفريدة الخاصة بك.

مع Cody ، يمكن للشركات تسخير قوة الذكاء الاصطناعي لإنشاء مساعد شخصي وذكي يلبي احتياجاتهم على وجه التحديد ، مما يجعله إضافة واعدة لعالم حلول الأعمال التي تعتمد على الذكاء الاصطناعي.

انقر هنا لقراءة ورقة بحث ميتا حول اللاما 2. جرب اللاما 2 هنا.