O poder do GPT-3.5 16K

Deverá atualizar para a versão paga do Cody? Eis a razão pela qual o pode querer fazer.

Há alguns dias, lançámos um modelo mais recente para todos os nossos utilizadores pagos, logo após o lançamento do OpenAI: GPT-3.5 16k. Por muito intimidante que possa parecer, pode ser um fator de mudança para a sua empresa. Neste blogue, vamos aprofundar os casos de utilização do GPT-3.5 16k, explorar as suas vantagens e realçar as suas diferenças em relação ao modelo GPT-3.5 existente e ao mais recente GPT-4 topo de gama.

O que é o GPT-3.5 16K?

Se já utilizou a versão gratuita do Cody, talvez já esteja familiarizado com o modelo GPT-3.5 básico, que utiliza o modelo gpt-3.5-turbo da OpenAI. Este modelo é a escolha popular para muitos utilizadores, uma vez que oferece acessibilidade, velocidade e fiabilidade na maioria dos casos. Por outro lado, o GPT-3.5-16k utiliza o modelo gpt-3.5-turbo-16k da OpenAI, que é uma extensão do gpt-3.5-turbo. A diferença significativa reside no aspeto “16k”.

O que é 16K?

O sufixo ’16K’ indica que o modelo tem uma janela de contexto de 16.000 tokens, um aumento significativo em relação aos 4.096 tokens actuais. No nosso blogue anterior, explicámos em pormenor o que são os tokens. Uma janela de contexto mais pequena nos modelos pode resultar em várias limitações, incluindo:

- Falta de relevância: Com uma janela de contexto limitada, o modelo pode ter dificuldade em captar e manter a relevância para o contexto mais alargado de uma conversa ou tarefa.

- Incapacidade de manter o contexto: Uma janela de contexto mais pequena pode fazer com que seja difícil para o modelo recordar e fazer referência a informações de partes anteriores de uma conversa, levando a inconsistências e dificuldades em manter um diálogo coerente.

- Restrições ao comprimento das consultas de entrada: Janelas de contexto mais curtas impõem restrições ao comprimento das consultas de entrada, dificultando o fornecimento de informações completas ou a formulação de perguntas complexas.

- Limitações do contexto da base de conhecimentos: Uma janela de contexto mais pequena pode enfrentar limitações na incorporação de conhecimentos de documentos relevantes do conhecimento devido ao limite de ingestão de dados.

Vantagens de uma janela de contexto maior

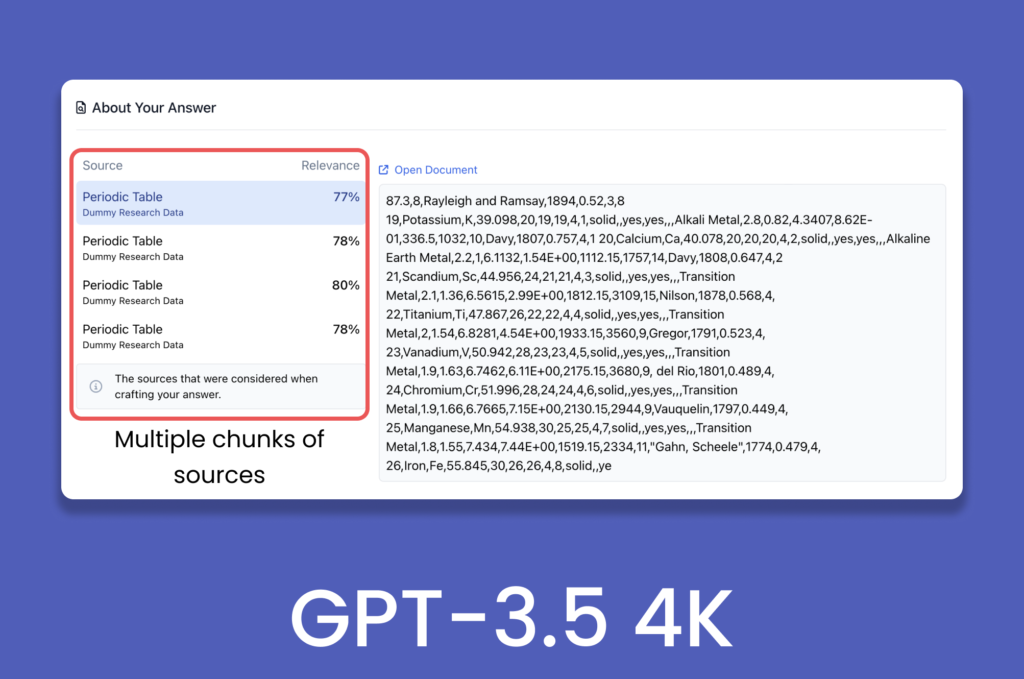

Uma pergunta pode surgir na mente de algumas pessoas: Como é que o GPT-3.5 é capaz de processar mais de 1000 páginas web e documentos no Cody, apesar da sua capacidade de apenas 4096 tokens? Com os avanços no domínio da IA generativa, fornecer contexto não significa simplesmente alimentar todo o documento com modelos linguísticos como o GPT-3.5 Turbo. Os processos de backend, como chunking, embeddings e bases de dados vectoriais, são utilizados para pré-processar os dados, mantendo a relevância dentro dos chunks e permitindo que o modelo navegue na janela de contexto predefinida.

No cenário atual, uma janela de contexto maior melhoraria o desempenho geral da IA ao acomodar entradas maiores e mais complexas, reduzindo simultaneamente o número de transacções de armazenamento de vectores necessárias para gerar uma resposta. Uma vez que a janela de contexto engloba tanto a entrada como a saída, uma janela maior também permitiria ao modelo dar respostas elaboradas e coerentes, mantendo o contexto da conversação.

Uma janela de contexto maior também ajudaria a mitigar quaisquer alucinações que possam ocorrer quando o limite de tokens numa conversa é excedido.

GPT-3.5 Turbo 16K v/s GPT-4

Embora gpt-3.5-turbo-16k seja a versão mais recente da OpenAI, gpt-4 continua a superá-la em vários aspectos, como a compreensão do contexto visual, a criatividade melhorada, a coerência e o desempenho multilingue. A única área em que o GPT-3.5-16k se destaca é a janela de contexto, uma vez que o GPT-4 está atualmente disponível na variante de 8k, com a variante de 32k ainda a ser lançada gradualmente.

Entretanto, até que a versão de 32k do gpt-4 se torne amplamente acessível, o GPT-3.5-16k destaca-se pela sua maior janela de contexto. Se estiver especificamente à procura de um modelo que ofereça uma janela de contexto mais extensa, o GPT-3.5-16k é a escolha ideal.

Casos de utilização de uma janela de contexto maior

- Apoio ao cliente: Uma janela de contexto maior aumenta a memória de curto prazo do modelo, tornando-o adequado para aplicações que envolvam apoio ao cliente, preenchimento de formulários e recolha de dados do utilizador. Permite que o modelo mantenha o contexto durante um período mais longo, conduzindo a respostas mais relevantes aos dados do utilizador, como nomes, IDs de clientes, reclamações e feedback.

- Formação de funcionários: A utilização da Cody para fins de formação dos empregados revela-se altamente eficaz. A formação dos empregados envolve frequentemente dados extensivos relacionados com actividades, etapas e processos empresariais. Para manter a relevância contextual ao longo do programa de formação, torna-se necessário incorporar todo o historial de conversação do formando. Uma janela de contexto maior permite a inclusão de mais informações históricas, facilitando uma experiência de formação mais abrangente e eficaz.

- Análise de dados: As tarefas que envolvem a análise financeira e a inferência estatística exigem frequentemente o processamento de grandes volumes de dados para obter informações significativas. Com uma janela de contexto maior, o modelo pode reter mais informações relevantes durante o cálculo, o que resulta numa análise mais coerente e exacta. Por exemplo, a comparação de balanços e o desempenho global de uma empresa ano após ano podem ser executados de forma mais eficaz com uma janela de contexto maior.

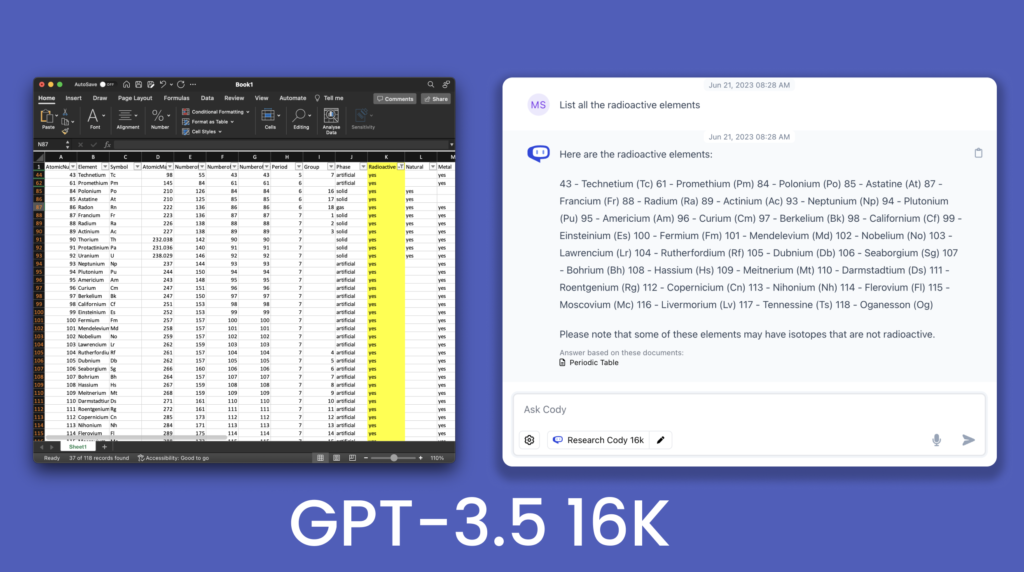

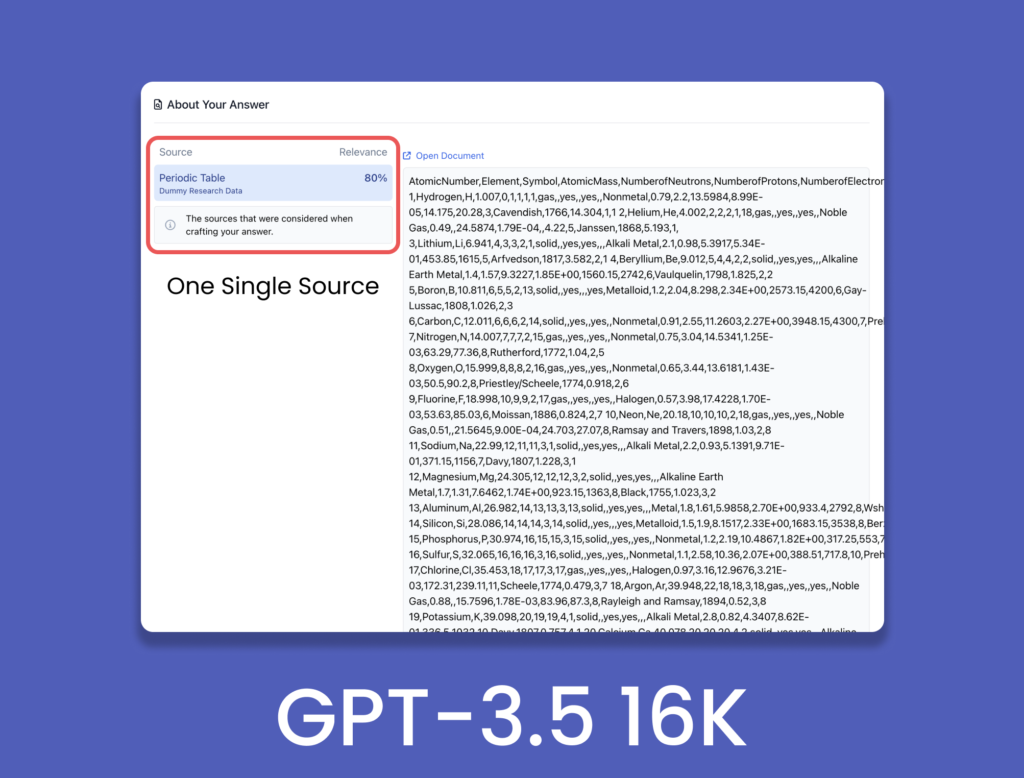

Comparação entre GPT-3.5 4K v/s 16K

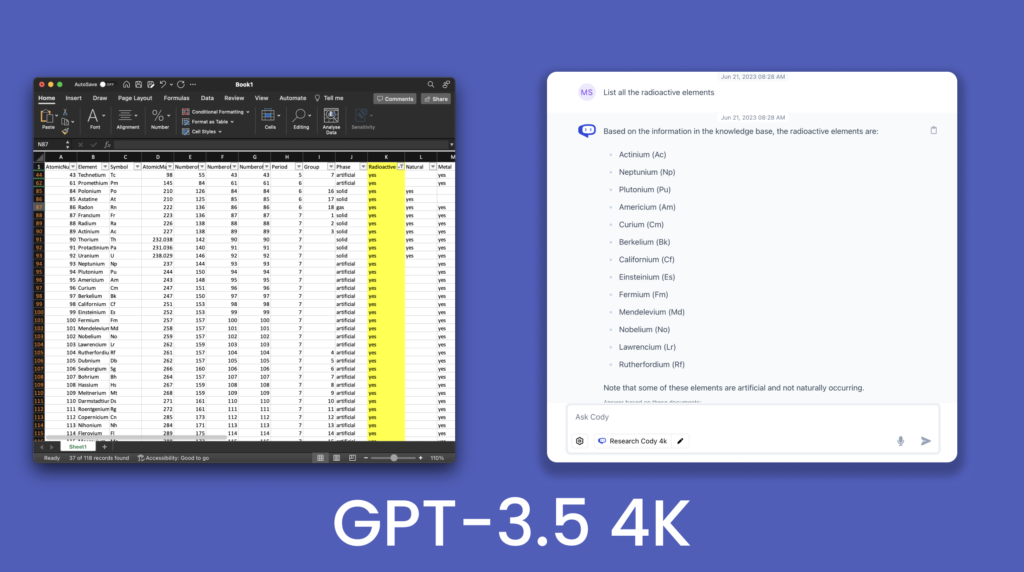

Para demonstrar as melhorias no modelo de 16K, consultámos um ficheiro .csv da Tabela Periódica que contém 118 elementos e as suas características.

Da comparação, é visível que a GPT-3.5 4K não foi capaz de produzir todos os elementos radioactivos na sua resposta e ignorou alguns elementos. Em contrapartida, o GPT-3.5 16K produziu quase todos os elementos radioactivos presentes na tabela fornecida. Este facto demonstra a melhoria da elaboração das respostas devido à maior janela de contexto. Este foi apenas um pequeno vislumbre do potencial da janela de contexto de 16k, existindo uma infinidade de aplicações e implementações da mesma. Com o GPT-4 32K no pipeline, o modelo 16K pode facilitar uma transição mais suave para uma janela de contexto maior.

Deve atualizar?

A janela de contexto maior é, sem dúvida, uma atualização significativa e não apenas um truque. Uma melhor compreensão do contexto desempenha um papel crucial na melhoria da qualidade das respostas, e uma janela de contexto mais alargada abre um potencial substancial para estes modelos de modelos de linguagem (LLM). Ao permitir uma compreensão mais alargada do histórico da conversação e das pistas contextuais, os LLM podem fornecer resultados mais exactos e contextualmente adequados.

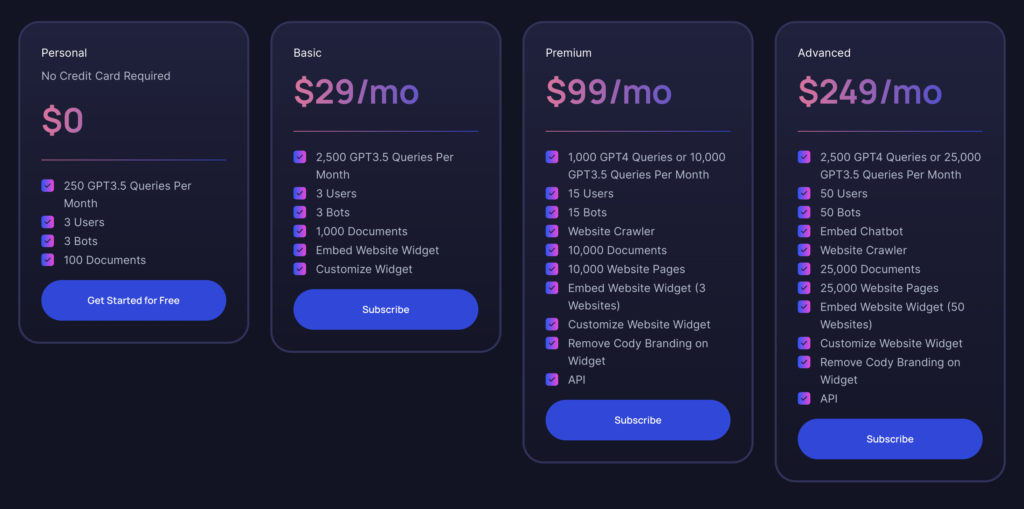

Como mencionado anteriormente, a variante de 16K do GPT-3.5 está disponível para todos os utilizadores a partir do Plano Básico. Se já utiliza o plano Pessoal (gratuito) há algum tempo, já deve ter experimentado as capacidades oferecidas pelo Cody. O Plano Básico oferece uma excelente relação qualidade/preço, especialmente se não necessitar das funcionalidades adicionais do GPT-4. É adequado para indivíduos que estão a construir um bot como um projeto ou um protótipo para o seu negócio com a opção de modelo adicional GPT-3.5 16K. No futuro, quando lançarmos a variante GPT-4 32K, pode sempre atualizar para o plano premium quando necessitar de mais tokens.

Para as empresas de maior dimensão, o Plano Avançado é a opção mais potente, que satisfaz os requisitos de utilização intensiva de recursos e de elevado volume. Oferece capacidades abrangentes para satisfazer as exigências das operações em grande escala.