LLaMA 2: Modelo de IA de fonte aberta do Meta

O mais recente LLM da cidade vale a pena?

Há alguns dias, a Meta lançou a sua última versão do LLM, denominada Llama 2, em colaboração com a Microsoft. Se tem seguido a moda do LLM, é provável que já tenha ouvido falar dele ou mesmo lido sobre as suas novas funcionalidades. Para simplificar as coisas, vamos enumerar quatro razões pelas quais o Llama 2 está a gerar tanto entusiasmo e como se compara com alguns dos melhores LLM.

Gratuito para investigação e utilização comercial

Uma razão importante que despertou o interesse das pessoas pela Llama 2 foi o facto de a Meta ter tornado todo o modelo gratuito para quase toda a gente, exceto para algumas grandes empresas que podem ter determinadas condições. Esta mudança abre oportunidades interessantes para quem está a pensar em criar a sua própria empresa ou aventurar-se no mundo da IA generativa. Esta é a altura ideal para mergulhar nas águas da IA, especialmente com um modelo linguístico deste calibre a que se pode aceder livremente. Embora já existissem vários modelos de código aberto disponíveis, nenhum deles provinha de uma empresa com a estatura da Meta e podia servir como concorrente direto da GPT.

“Houve lançamentos públicos de LLMs pré-treinados (como BLOOM (Scao et al., 2022), LLaMa-1 (Touvron et al., 2023) e Falcon (Penedo et al., 2023)) que correspondem ao desempenho de concorrentes pré-treinados fechados como GPT-3 (Brown et al, 2020) e Chinchilla (Hoffmann et al., 2022), mas nenhum destes modelos é um substituto adequado para LLMs de “produtos” fechados, como o ChatGPT, BARD e Claude.” – Artigo de investigação Meta

Segurança

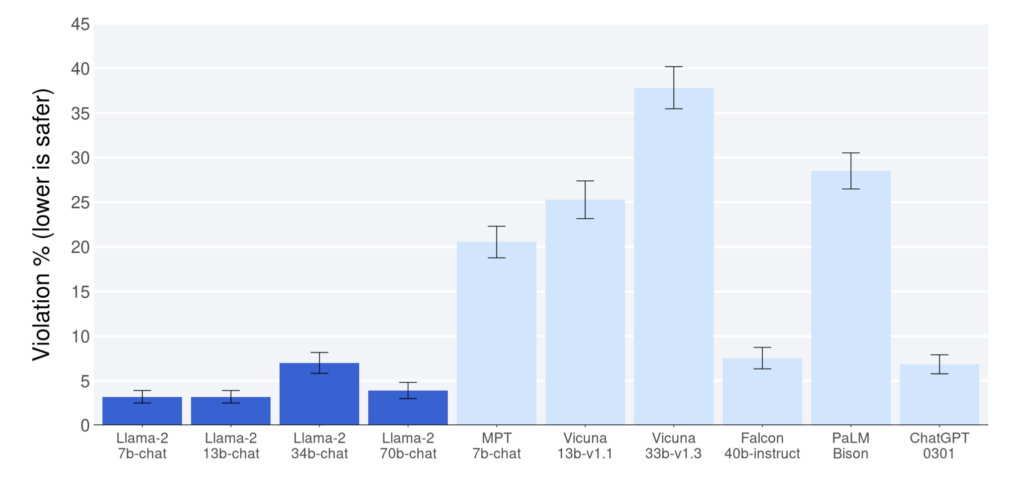

Com base nos relatórios publicados no documento de investigação Meta, a Llama 2 demonstrou um desempenho superior em comparação com outros modelos de fonte aberta nos parâmetros de referência de utilidade e segurança. Nestes aspectos, superou mesmo o ChatGPT (modelos 7b, 13b, 70b). No entanto, é importante notar que o documento de investigação reconhece a possibilidade de os dados serem tendenciosos, favorecendo a Lhama 2, o que deve ser tido em consideração ao interpretar os resultados. No entanto, mesmo que o Llama 2 se aproxime da referência ChatGPT, merece ser elogiado.

Um dos factores mais importantes que contribuem para a segurança da Llama 2 é a sua privacidade de dados. Ao contrário de alguns modelos, o Llama 2 não requer o envio dos seus dados para um servidor externo, como o OpenAI, para obter respostas. Este atributo único torna o modelo particularmente valioso para casos de utilização críticos e sensíveis, uma vez que ajuda a proteger os dados dos utilizadores e a manter a sua privacidade. Os utilizadores podem executar o modelo em servidores privados com os seus dados contidos na sua infraestrutura.

Código aberto

Os LLM mais populares atualmente em uso funcionam como caixas negras, com os utilizadores a terem uma visão limitada do seu funcionamento. Em contrapartida, os modelos de código aberto oferecem uma abordagem transparente, permitindo aos utilizadores compreender o seu funcionamento interno. Esta transparência inspira confiança e segurança na utilização desses modelos, apesar dos desafios que podem enfrentar, como a geração de spam ou desinformação.

Além disso, a natureza de fonte aberta destes modelos incentiva os esforços de colaboração, conduzindo a uma melhoria e desenvolvimento contínuos no domínio dos LLM. Consequentemente, os modelos de código aberto desempenham um papel crucial na promoção dos avanços no mundo dos modelos linguísticos.

“E acreditamos que é mais seguro. Abrir o acesso aos modelos de IA actuais significa que uma geração de programadores e investigadores pode testá-los, identificando e resolvendo problemas rapidamente, como uma comunidade. Ao ver como estas ferramentas são utilizadas por outros, as nossas próprias equipas podem aprender com elas, melhorar essas ferramentas e corrigir vulnerabilidades.” – Sítio Web Meta

Embora a Llama 2 esteja licenciada de forma aberta, a Meta ainda não divulgou os dados em que foi treinada, o que continua a ser um problema em termos de privacidade dos dados dos utilizadores da Meta. A Meta diz que “fez um esforço para remover dados de determinados sítios conhecidos por conterem um elevado volume de informações pessoais sobre indivíduos privados” no documento de investigação Llama 2, mas não enumerou quais são esses sítios.

Desempenho

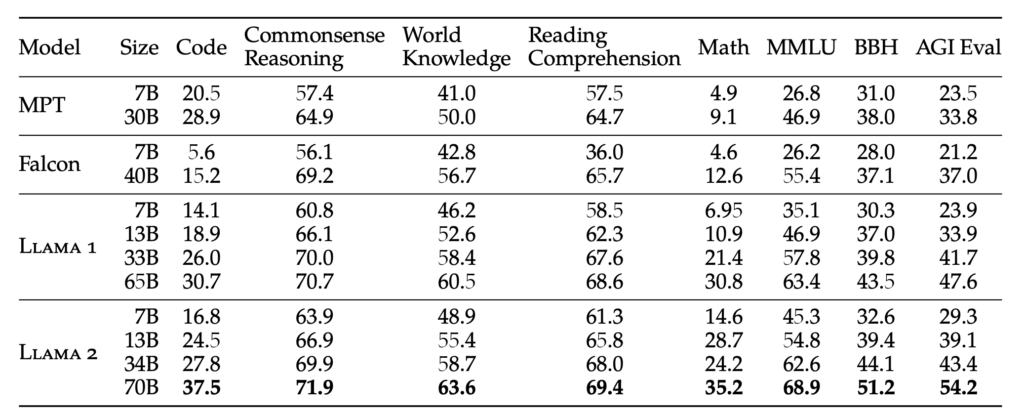

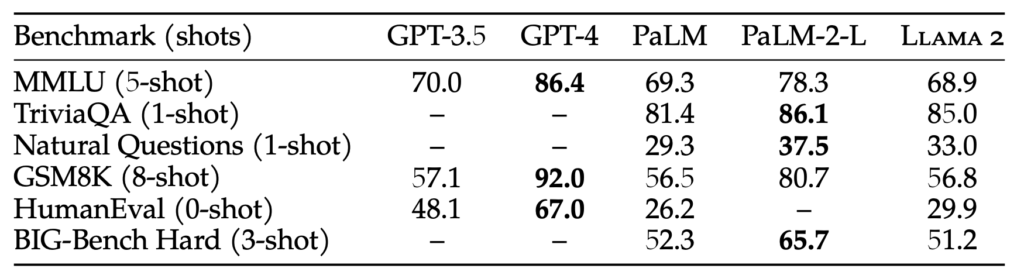

A Llama 2 está disponível em quatro pesos diferentes: 7B, 13B, 34B e 70B. O peso representa o número de parâmetros com que o modelo é treinado. Geralmente, parâmetros maiores resultam em respostas mais precisas e fiáveis, mas também requerem mais recursos computacionais. Para melhorar as características humanas do modelo, a Llama 2 é sujeita a um ajustamento fino utilizando o ajustamento de instruções e o método RLHF (Reinforcement Learning with Human Feedback), que também é utilizado pelo GPT.

Embora o tamanho do parâmetro de 70B seja substancial, ainda fica aquém do GPT-3.5, que tem um tamanho de parâmetro de 175B. Como resultado, o desempenho do Llama 2 pode não corresponder ao do GPT-3.5, mas os testes de referência indicam uma concorrência próxima, mesmo com o seu tamanho de parâmetro mais pequeno. Apesar desta diferença, o Llama 2 tem um desempenho superior a todos os modelos de código aberto atualmente disponíveis.

“O RLHF é um procedimento de treino de modelos que é aplicado a um modelo linguístico aperfeiçoado para alinhar ainda mais O modelo de comportamento com as preferências humanas e o seguimento de instruções. Recolhemos dados que representam amostras empíricas das preferências humanas, em que os anotadores humanos seleccionam qual dos dois resultados do modelo preferem. Este feedback humano é posteriormente utilizado para treinar um modelo de recompensa, que aprende padrões nas preferências dos anotadores humanos e pode então automatizar as decisões de preferência.” – Documento de investigação Meta

Conclusão

Há, de facto, uma multiplicidade de modelos de código aberto a surgir e, com o lançamento do Llama 2, as possibilidades parecem ilimitadas. Embora possa demorar algum tempo até que estes modelos de código aberto possam competir diretamente com algo tão avançado como o GPT-4, o entusiasmo reside em obter um modelo que se aproxime das capacidades do GPT-3.5. Este progresso é, por si só, verdadeiramente notável.

Olhando para o futuro, à medida que a formação LLM se torna mais eficiente, a possibilidade de ter um ChatGPT personalizado, ajustado com os seus dados no seu dispositivo local, torna-se uma perspetiva tentadora. Uma plataforma que oferece essas capacidades é a Cody, um assistente inteligente de IA concebido para apoiar as empresas em vários aspectos. Tal como o ChatGPT, o Cody pode ser treinado nos dados da sua empresa, equipa, processos e clientes, utilizando a sua base de conhecimentos exclusiva.

Com o Cody, as empresas podem tirar partido do poder da IA para criar um assistente personalizado e inteligente que se adapta especificamente às suas necessidades, o que o torna uma adição promissora ao mundo das soluções empresariais orientadas para a IA.

Clique aqui para ler o documento de meta-investigação sobre a Llama 2. Experimente o Llama 2 aqui.