Moc GPT-3.5 16K

Czy powinieneś przejść na płatną wersję Cody? Oto dlaczego warto to zrobić.

Kilka dni temu wydaliśmy nowszy model dla wszystkich naszych płatnych użytkowników zaraz po premierze OpenAI: GPT-3.5 16k. Choć może się to wydawać onieśmielające, może to być przełom dla Twojej firmy. W tym blogu zagłębimy się w przypadki użycia GPT-3.5 16k, zbadamy jego zalety i podkreślimy, w jaki sposób różni się on od istniejącego modelu GPT-3.5 i najnowszego, wyższej klasy GPT-4.

Czym jest GPT-3.5 16K?

Jeśli korzystałeś wcześniej z darmowej wersji Cody’ego, możesz być już zaznajomiony z waniliowym modelem GPT-3.5, który wykorzystuje model OpenAI gpt-3.5-turbo. Model ten jest popularnym wyborem wielu użytkowników, ponieważ oferuje przystępną cenę, szybkość i niezawodność w większości przypadków. Z drugiej strony, GPT-3.5-16k wykorzystuje model OpenAI gpt-3.5-turbo-16k, który jest rozszerzeniem modelu gpt-3.5-turbo. Znacząca różnica polega na aspekcie “16k”.

Co to jest 16K?

Przyrostek “16K” wskazuje, że model ma okno kontekstowe składające się z 16 000 tokenów, co stanowi znaczny wzrost w stosunku do istniejących 4096 tokenów. Na naszym poprzednim blogu wyjaśniliśmy szczegółowo, czym są tokeny. Mniejsze okno kontekstowe w modelach może skutkować kilkoma ograniczeniami, w tym:

- Brak trafności: Przy ograniczonym oknie kontekstowym model może mieć trudności z uchwyceniem i utrzymaniem znaczenia w szerszym kontekście rozmowy lub zadania.

- Niezdolność do utrzymania kontekstu: Mniejsze okno kontekstowe może utrudniać modelowi zapamiętywanie i odwoływanie się do informacji z wcześniejszych części rozmowy, prowadząc do niespójności i trudności w utrzymaniu spójnego dialogu.

- Ograniczenia dotyczące długości zapytań wejściowych: Krótsze okna kontekstowe nakładają ograniczenia na długość zapytań wejściowych, utrudniając dostarczanie wyczerpujących informacji lub zadawanie złożonych pytań.

- Ograniczenia kontekstu bazy wiedzy: Mniejsze okno kontekstowe może napotkać ograniczenia we włączaniu wiedzy z odpowiednich dokumentów do bazy wiedzy ze względu na limit pozyskiwania danych.

Zalety większego okna kontekstowego

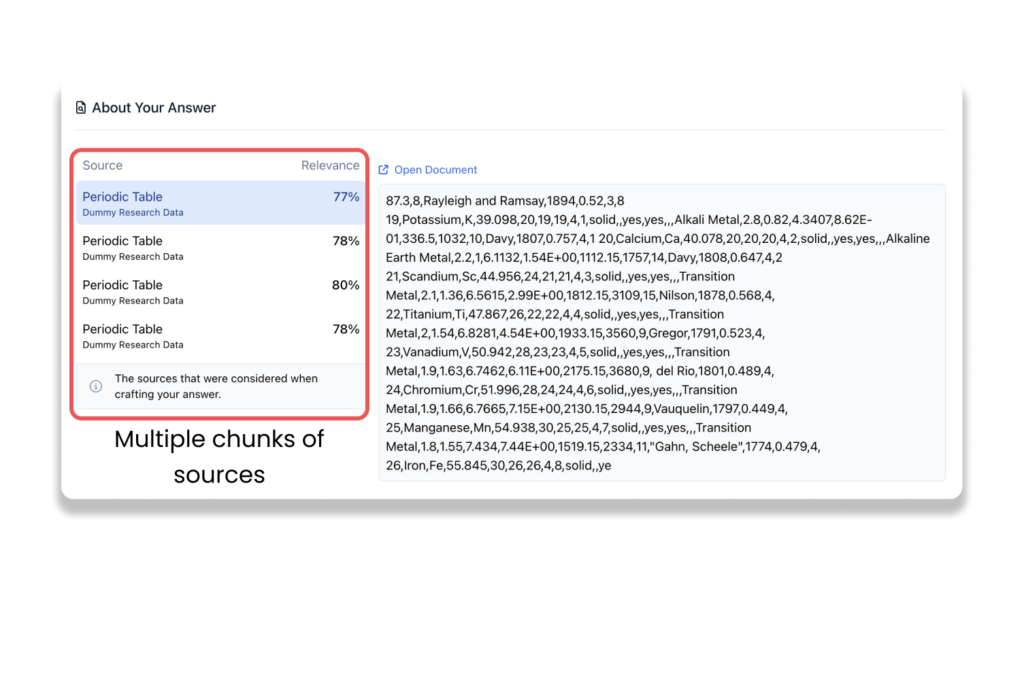

W głowach kilku osób może pojawić się pytanie: w jaki sposób GPT-3.5 jest w stanie przetworzyć ponad 1000 stron internetowych i dokumentów na Cody, pomimo pojemności zaledwie 4096 tokenów? Wraz z postępem w dziedzinie generatywnej sztucznej inteligencji, zapewnienie kontekstu nie oznacza po prostu dostarczenia całego dokumentu do modeli językowych, takich jak GPT-3.5 Turbo. Procesy zaplecza, takie jak chunking, embeddings i wektorowe bazy danych, są wykorzystywane do wstępnego przetwarzania danych, zachowując trafność w ramach fragmentów i umożliwiając modelowi poruszanie się po predefiniowanym oknie kontekstowym.

W obecnym scenariuszu większe okno kontekstowe zwiększyłoby ogólną wydajność sztucznej inteligencji, dostosowując się do większych i bardziej złożonych danych wejściowych, jednocześnie zmniejszając liczbę transakcji przechowywania wektorów wymaganych do wygenerowania odpowiedzi. Ponieważ okno kontekstowe obejmuje zarówno dane wejściowe, jak i wyjściowe, większe okno umożliwiłoby modelowi udzielanie rozbudowanych i spójnych odpowiedzi przy jednoczesnym zachowaniu kontekstu konwersacji.

Większe okno kontekstowe pomogłoby również złagodzić wszelkie halucynacje, które mogą wystąpić po przekroczeniu limitu tokenów w rozmowie.

GPT-3.5 Turbo 16K v/s GPT-4

Chociaż gpt-3.5-turbo-16k jest najnowszą wersją OpenAI, gpt-4 nadal przewyższa ją w różnych aspektach, takich jak rozumienie kontekstu wizualnego, lepsza kreatywność, spójność i wielojęzyczna wydajność. Jedynym obszarem, w którym GPT-3.5-16k przoduje, jest okno kontekstowe, ponieważ GPT-4 jest obecnie dostępny w wariancie 8k, a wariant 32k jest nadal stopniowo wdrażany.

W międzyczasie, dopóki 32-kilogramowa wersja gpt-4 nie stanie się powszechnie dostępna, GPT-3.5-16k wyróżnia się większym oknem kontekstowym. Jeśli szukasz modelu oferującego szersze okno kontekstowe, GPT-3.5-16k będzie idealnym wyborem.

Przypadki użycia większego okna kontekstowego

- Obsługa klienta: Większe okno kontekstowe zwiększa pamięć krótkotrwałą modelu, dzięki czemu dobrze nadaje się on do zastosowań związanych z obsługą klienta, wypełnianiem formularzy i gromadzeniem danych użytkownika. Umożliwia to modelowi utrzymywanie kontekstu przez dłuższy czas, co prowadzi do bardziej trafnych odpowiedzi na dane wejściowe użytkownika, takie jak nazwy, identyfikatory klientów, skargi i opinie.

- Szkolenie pracowników: Wykorzystanie Cody do celów szkoleniowych pracowników okazuje się bardzo skuteczne. Szkolenia pracowników często obejmują obszerne dane związane z działaniami biznesowymi, krokami i procesami. Aby zachować kontekstowość w całym programie szkoleniowym, konieczne staje się uwzględnienie całej historii konwersacji uczestnika szkolenia. Większe okno kontekstowe pozwala na uwzględnienie większej ilości informacji historycznych, ułatwiając bardziej kompleksowe i efektywne szkolenie.

- Analiza danych: Zadania obejmujące analizę finansową i wnioskowanie statystyczne często wymagają przetwarzania dużych ilości danych w celu uzyskania istotnych informacji. Dzięki większemu oknu kontekstowemu model może przechowywać więcej istotnych informacji podczas obliczeń, co skutkuje bardziej spójną i dokładną analizą. Na przykład porównywanie bilansów i ogólnych wyników firmy rok do roku może być wykonywane bardziej efektywnie w większym oknie kontekstowym.

Porównanie GPT-3.5 4K vs 16K

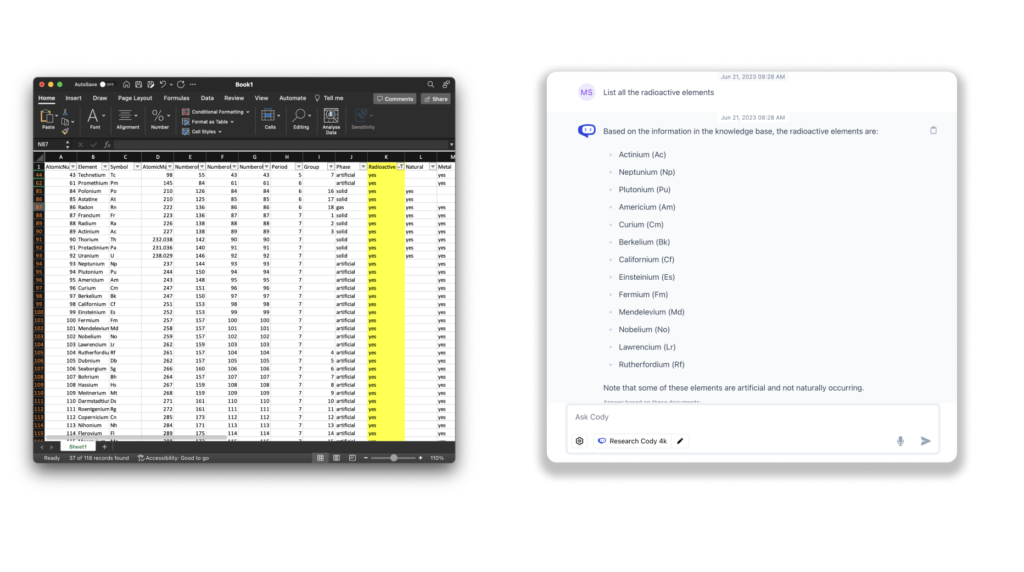

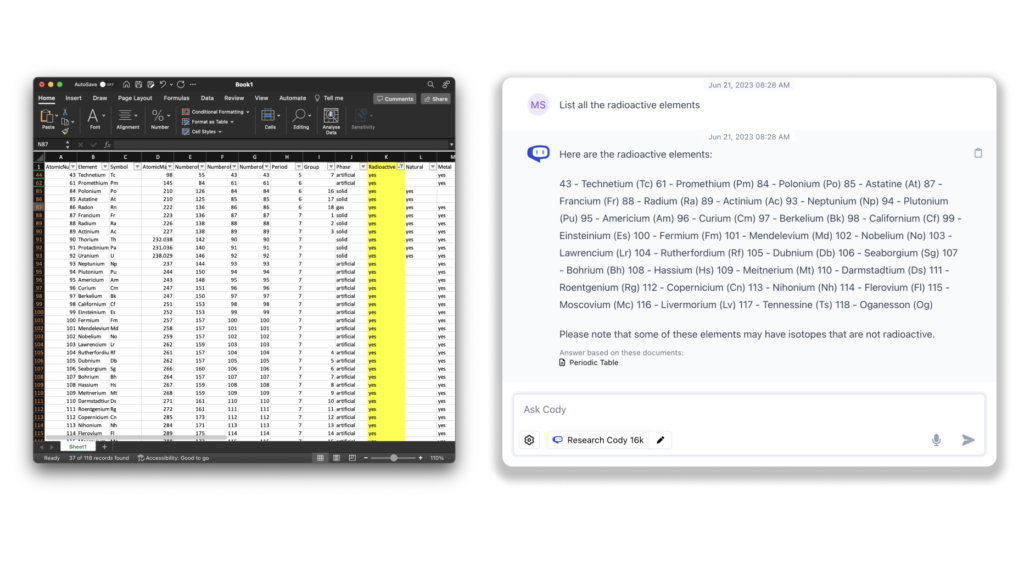

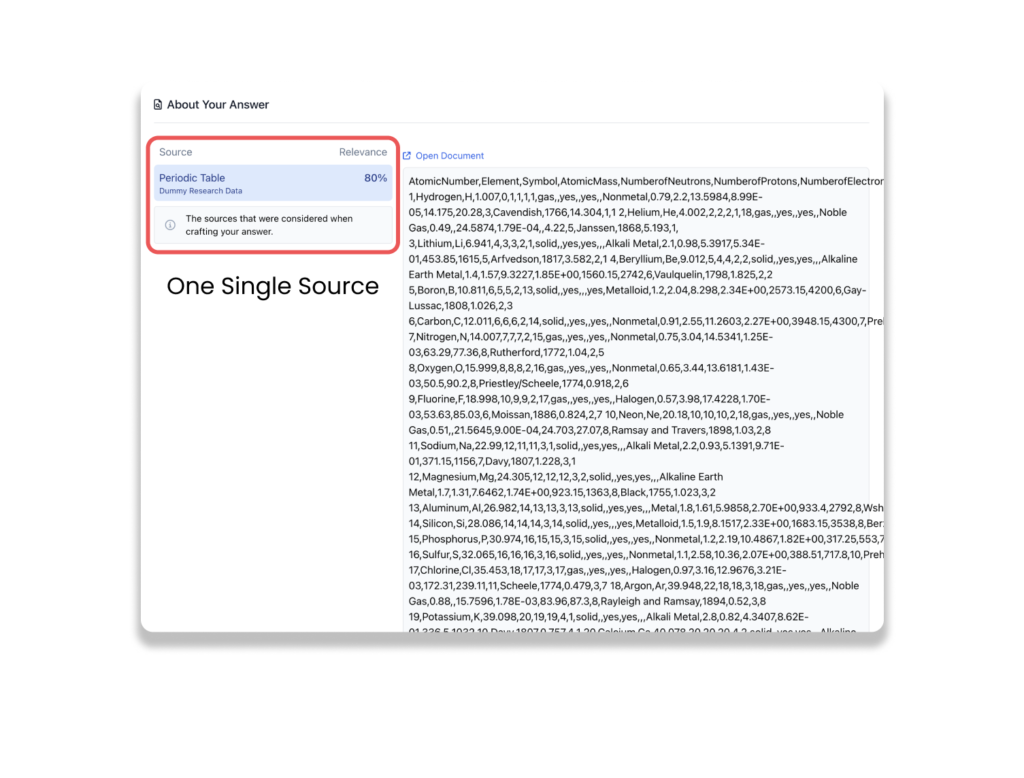

Aby zademonstrować ulepszenia w modelu 16K, zapytaliśmy o plik .csv układu okresowego zawierający 118 pierwiastków i ich cechy.

Z porównania widać, że GPT-3.5 4K nie był w stanie wyprodukować wszystkich pierwiastków promieniotwórczych w swojej odpowiedzi i pominął niektóre pierwiastki. Z kolei GPT-3.5 16K wyprodukował prawie wszystkie pierwiastki promieniotwórcze obecne w podanej tabeli. Świadczy to o lepszym opracowaniu odpowiedzi dzięki większemu oknu kontekstowemu. To był tylko mały rzut oka na potencjał, jaki kryje w sobie okno kontekstowe 16k, z nieskończoną liczbą aplikacji i implementacji tego samego. Z GPT-4 32K w potoku, model 16K może ułatwić płynniejsze przejście do większego okna kontekstowego.

Czy powinieneś dokonać aktualizacji?

Większe okno kontekstowe jest niewątpliwie znaczącą aktualizacją, a nie tylko sztuczką. Lepsze zrozumienie kontekstu odgrywa kluczową rolę w poprawie jakości odpowiedzi, a większe okno kontekstowe uwalnia znaczny potencjał tych modeli modeli językowych (LLM). Pozwalając na szersze zrozumienie historii konwersacji i wskazówek kontekstowych, LLM może dostarczać bardziej dokładne i kontekstowo odpowiednie wyniki.

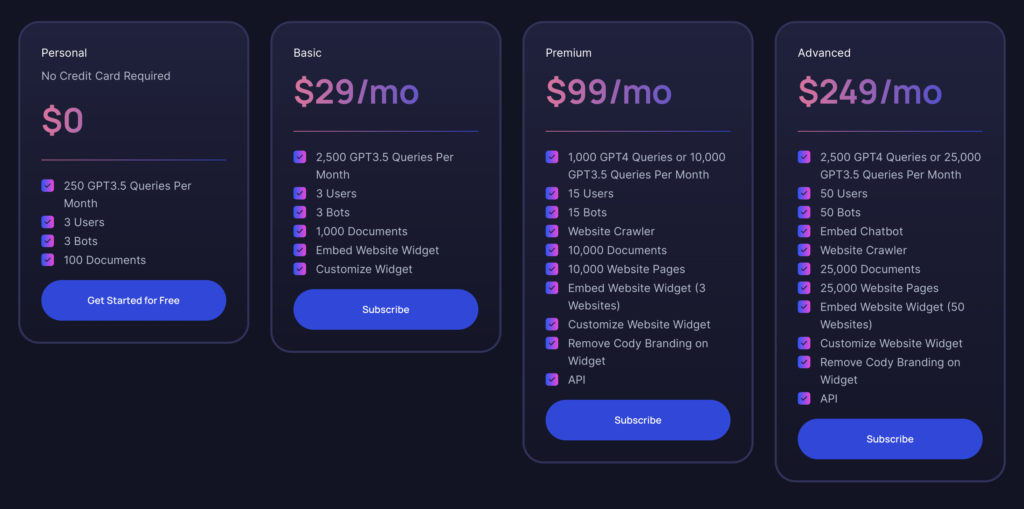

Jak wspomniano wcześniej, wariant 16K GPT-3.5 jest dostępny dla wszystkich użytkowników począwszy od planu podstawowego. Jeśli od jakiegoś czasu korzystasz z planu Personal (darmowego), to z pewnością doświadczyłeś już możliwości oferowanych przez Cody. Plan podstawowy zapewnia doskonały stosunek jakości do ceny, zwłaszcza jeśli nie potrzebujesz dodatkowych funkcji GPT-4. Jest odpowiedni dla osób, które budują bota jako projekt lub prototyp dla swojej firmy, z dodatkowym wyborem modelu GPT-3.5 16K. W przyszłości, gdy wydamy wariant GPT-4 32K, zawsze będzie można uaktualnić do planu premium, gdy pojawi się potrzeba większej liczby tokenów.

W przypadku większych przedsiębiorstw plan zaawansowany jest najpotężniejszą opcją, spełniającą wymagania dotyczące intensywnego wykorzystania zasobów i dużej ilości danych. Oferuje wszechstronne możliwości, aby sprostać wymaganiom operacji na dużą skalę.