LLaMA 2: Model sztucznej inteligencji Meta o otwartym kodzie źródłowym

Czy najnowsze LLM w mieście jest warte szumu?

Kilka dni temu Meta wydała najnowszą wersję LLM o nazwie Llama 2 we współpracy z Microsoft. Jeśli śledzisz szum wokół LLM, być może już o nim słyszałeś lub nawet czytałeś o jego nowych funkcjach. Aby uprościć sprawę, wymienimy cztery powody, dla których Llama 2 generuje tak wiele szumu i jak wypada w porównaniu z niektórymi z najlepszych LLM.

Bezpłatnie do celów badawczych i komercyjnych

Jednym z istotnych powodów, dla których ludzie zainteresowali się Llama 2, jest fakt, że Meta uczyniła cały model darmowym dla prawie wszystkich, z wyjątkiem niektórych dużych przedsiębiorstw, które mogą mieć pewne warunki. To posunięcie otwiera ekscytujące możliwości dla osób myślących o założeniu własnej firmy lub zapuszczeniu się w świat generatywnej sztucznej inteligencji. Teraz jest idealny czas, aby zanurzyć się w wodach sztucznej inteligencji, zwłaszcza gdy model językowy tego kalibru jest swobodnie dostępny. Chociaż dostępnych było już wiele modeli open-source, żaden z nich nie pochodził od firmy o randze Meta i nie mógł służyć jako bezpośrednia konkurencja dla GPT.

“Pojawiły się publiczne wersje wstępnie wytrenowanych LLM (takich jak BLOOM (Scao i in., 2022), LLaMa-1 (Touvron i in., 2023) i Falcon (Penedo i in., 2023)), które dorównują wydajnością zamkniętym wstępnie wytrenowanym konkurentom, takim jak GPT-3 (Brown i in., 2020) i Chinchilla (Hoffmann i in., 2022), 2020) i Chinchilla (Hoffmann i in., 2022), ale żaden z tych modeli nie jest odpowiednim substytutem dla zamkniętych “produktowych” LLM, takich jak ChatGPT, BARD i Claude”. – Meta Research Paper

Bezpieczeństwo

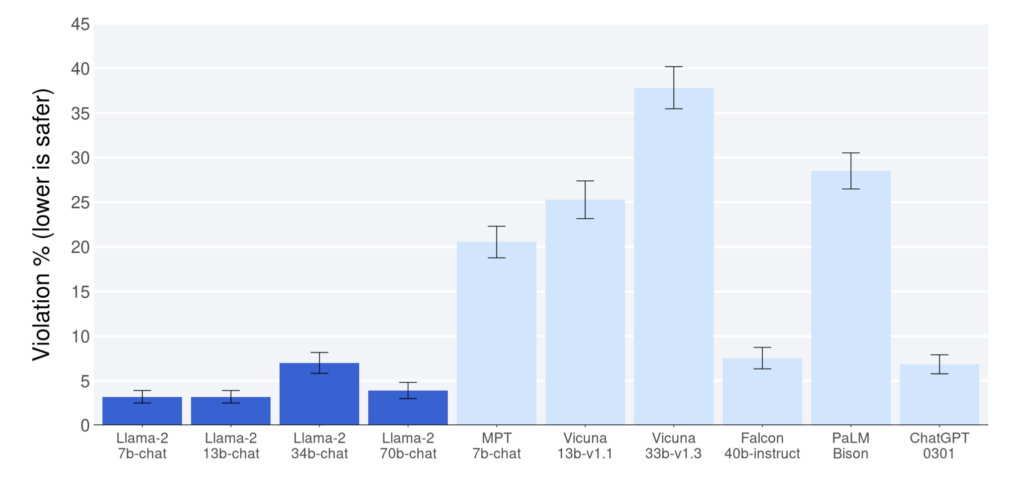

W oparciu o raporty opublikowane w artykule badawczym Meta, Llama 2 wykazała lepszą wydajność w porównaniu z innymi modelami open-source w benchmarku pomocności i bezpieczeństwa. W tych aspektach przewyższył nawet ChatGPT (modele 7b, 13b, 70b). Należy jednak zauważyć, że w artykule badawczym uznano możliwość stronniczych danych faworyzujących Llama 2, co należy wziąć pod uwagę podczas interpretacji wyników. Niemniej jednak, nawet jeśli Llama 2 zbliża się do benchmarku ChatGPT, zasługuje na pochwałę.

Jednym z najważniejszych czynników wpływających na bezpieczeństwo Llama 2 jest prywatność danych. W przeciwieństwie do niektórych modeli, Llama 2 nie wymaga wysyłania danych do zewnętrznego serwera, takiego jak OpenAI, w celu pobrania odpowiedzi. Ten unikalny atrybut sprawia, że model jest szczególnie cenny w krytycznych i wrażliwych przypadkach użycia, ponieważ pomaga chronić dane użytkowników i zachować ich prywatność. Użytkownicy mogą uruchamiać model na prywatnych serwerach, a ich dane są przechowywane w ich infrastrukturze.

Open Source

Najpopularniejsze obecnie systemy LLM działają jak czarne skrzynki, a ich użytkownicy mają ograniczony wgląd w ich funkcjonowanie. Z kolei modele open-source zapewniają przejrzyste podejście, pozwalając użytkownikom zrozumieć ich wewnętrzne działanie. Ta przejrzystość wzbudza zaufanie i pewność podczas korzystania z takich modeli, pomimo wyzwań, jakie mogą napotkać, takich jak generowanie spamu lub dezinformacji.

Ponadto, otwarty charakter tych modeli zachęca do współpracy, prowadząc do ciągłego doskonalenia i rozwoju w dziedzinie LLM. W rezultacie modele open-source odgrywają kluczową rolę w napędzaniu postępów w świecie modeli językowych.

“I wierzymy, że jest to bezpieczniejsze. Otwarcie dostępu do dzisiejszych modeli sztucznej inteligencji oznacza, że pokolenie deweloperów i badaczy może testować je w warunkach skrajnych, szybko identyfikując i rozwiązując problemy jako społeczność. Widząc, jak te narzędzia są używane przez innych, nasze własne zespoły mogą się od nich uczyć, ulepszać te narzędzia i naprawiać luki w zabezpieczeniach”. – Strona internetowa Meta

Mimo że Llama 2 jest licencjonowana w sposób otwarty, Meta nadal nie ujawniła danych, na których została przeszkolona, co nadal jest istotne z punktu widzenia prywatności danych użytkowników Meta. Meta twierdzi, że “dołożyła starań, aby usunąć dane z niektórych witryn, o których wiadomo, że zawierają dużą ilość danych osobowych osób prywatnych” w dokumencie badawczym Llama 2, ale nie wymieniła tych witryn.

Wydajność

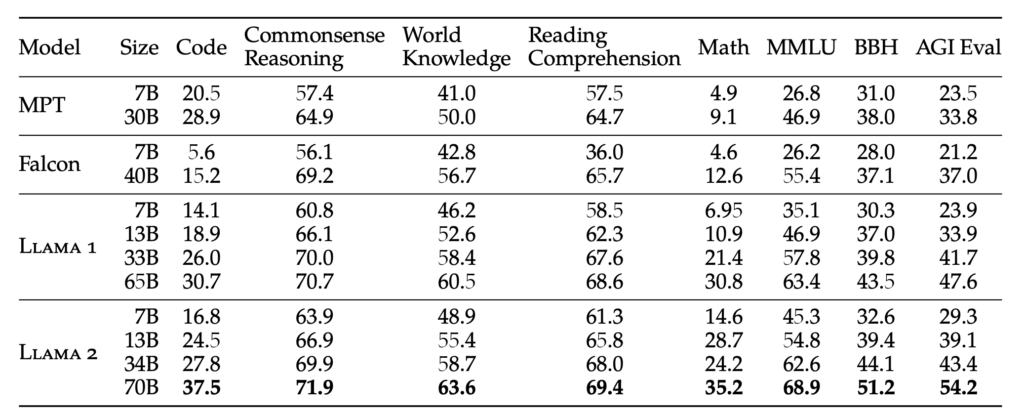

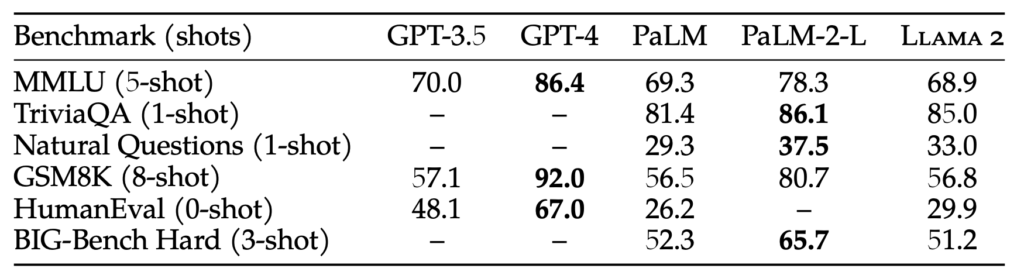

Llama 2 jest dostępna w czterech różnych gramaturach: 7B, 13B, 34B i 70B. Waga reprezentuje liczbę parametrów, na których trenowany jest model. Ogólnie rzecz biorąc, większe rozmiary parametrów skutkują dokładniejszymi i bardziej wiarygodnymi odpowiedziami, ale wymagają również większych zasobów obliczeniowych. Aby poprawić ludzką charakterystykę modelu, Llama 2 przechodzi dostrajanie za pomocą dostrajania instrukcji i metody RLHF (Reinforcement Learning with Human Feedback), która jest również używana przez GPT.

Chociaż rozmiar parametru 70B jest znaczny, to nadal jest on mniejszy niż w przypadku GPT-3.5, który ma rozmiar parametru 175B. W rezultacie wydajność Llama 2 może nie dorównywać GPT-3.5, ale testy porównawcze wskazują na bliską konkurencję nawet przy mniejszym rozmiarze parametrów. Pomimo tej różnicy, Llama 2 przewyższa wszystkie istniejące obecnie modele open-source.

“RLHF to procedura szkolenia modelu, która jest stosowana do precyzyjnie dostrojonego modelu językowego w celu dalszego wyrównania. zachowanie modelu z ludzkimi preferencjami i podążaniem za instrukcjami. Zbieramy dane, które reprezentują empirycznie próbkowane ludzkie preferencje, dzięki czemu ludzcy adnotatorzy wybierają, które z dwóch wyników modelu preferują. Te ludzkie opinie są następnie wykorzystywane do trenowania modelu nagród, który uczy się wzorców w preferencjach ludzkich adnotatorów, a następnie może zautomatyzować decyzje dotyczące preferencji”. – Meta Research Paper

Wnioski

Rzeczywiście pojawia się wiele modeli open-source, a wraz z wydaniem Llama 2 możliwości wydają się nieograniczone. Chociaż może minąć trochę czasu, zanim te modele open-source będą bezpośrednio konkurować z czymś tak zaawansowanym jak GPT-4, ekscytacja polega na uzyskaniu modelu, który zbliża się do możliwości GPT-3.5. Ten postęp sam w sobie jest naprawdę niezwykły.

Patrząc w przyszłość, w miarę jak szkolenia LLM stają się coraz bardziej wydajne, potencjał posiadania spersonalizowanego ChatGPT, dostosowanego do danych użytkownika na urządzeniu lokalnym, staje się kuszącą perspektywą. Jedną z platform oferujących takie możliwości jest Cody, inteligentny asystent AI dostosowany do wspierania firm w różnych aspektach. Podobnie jak ChatGPT, Cody może zostać przeszkolony w zakresie danych biznesowych, zespołu, procesów i klientów, korzystając z unikalnej bazy wiedzy.

Dzięki Cody firmy mogą wykorzystać moc sztucznej inteligencji do stworzenia spersonalizowanego i inteligentnego asystenta, który zaspokaja ich potrzeby, co czyni go obiecującym dodatkiem do świata rozwiązań biznesowych opartych na sztucznej inteligencji.

Kliknij tutaj, aby przeczytać Meta Research Paper na temat Llama 2. Wypróbuj Llama 2 tutaj.