La potencia de GPT-3.5 16K

¿Deberías pasarte a la versión de pago de Cody? He aquí por qué querrías hacerlo.

Hace unos días, lanzamos un modelo más nuevo para todos nuestros usuarios de pago justo después del lanzamiento de OpenAI: GPT-3.5 16k. Por intimidante que pueda parecer, puede cambiar las reglas del juego de su empresa. En este blog, profundizaremos en los casos de uso de GPT-3.5 16k, exploraremos sus ventajas y destacaremos en qué se diferencia del modelo GPT-3.5 existente y del último GPT-4 de gama alta.

¿Qué es GPT-3.5 16K?

Si ya has utilizado la versión gratuita de Cody, puede que estés familiarizado con el modelo vainilla GPT-3.5, que utiliza el modelo gpt-3.5-turbo de OpenAI. Este modelo es la elección popular de muchos usuarios, ya que ofrece asequibilidad, velocidad y fiabilidad en la mayoría de los casos. Por otro lado, el GPT-3.5-16k utiliza el modelo gpt-3.5-turbo-16k de OpenAI, que es una extensión del gpt-3.5-turbo. La diferencia significativa radica en el aspecto “16k”.

¿Qué es 16K?

El sufijo “16K” indica que el modelo tiene una ventana contextual de 16.000 fichas, lo que supone un aumento significativo respecto a las 4.096 fichas actuales. En nuestro blog anterior, explicamos en detalle qué son las fichas. Una ventana contextual más pequeña en los modelos puede acarrear varias limitaciones, entre ellas:

- Falta de relevancia: Con una ventana de contexto limitada, el modelo puede tener dificultades para captar y mantener la relevancia del contexto más amplio de una conversación o tarea.

- Incapacidad para mantener el contexto: Una ventana de contexto más pequeña puede dificultar que el modelo recuerde y haga referencia a información de partes anteriores de una conversación, lo que provoca incoherencias y dificultades para mantener un diálogo coherente.

- Restricciones en la longitud de las consultas: las ventanas contextuales más cortas imponen restricciones en la longitud de las consultas, lo que dificulta proporcionar información exhaustiva o formular preguntas complejas.

- Limitaciones del contexto de la base de conocimientos: Una ventana de contexto más pequeña puede enfrentarse a limitaciones a la hora de incorporar conocimiento de documentos relevantes del conocimiento debido al límite de ingestión de datos.

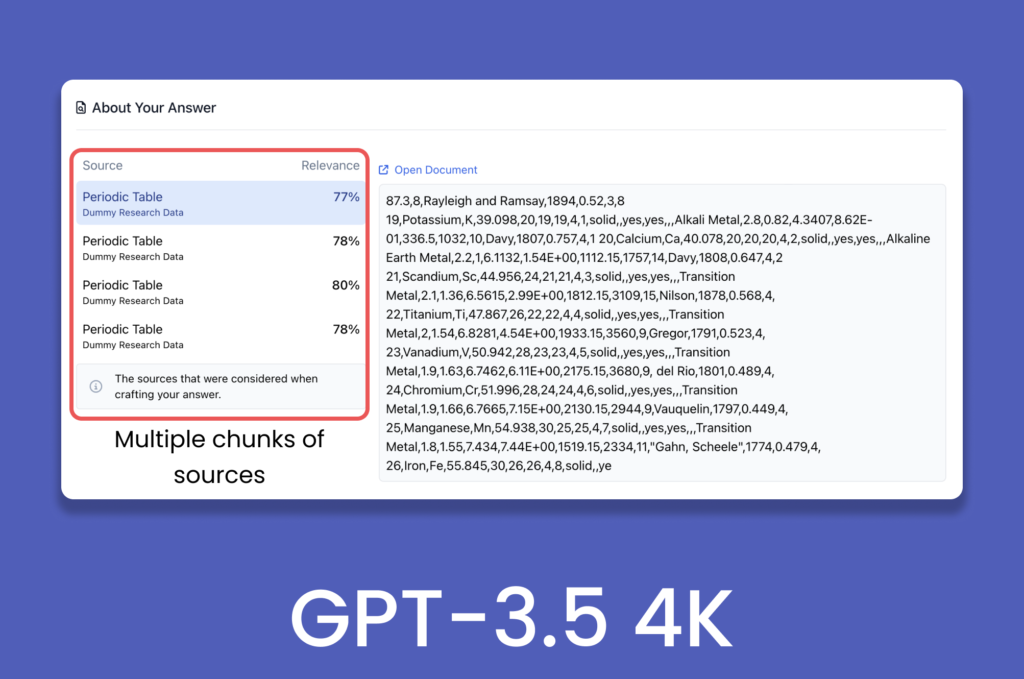

Ventajas de una ventana contextual más grande

A algunas personas podría surgirles una pregunta: ¿Cómo es posible que GPT-3.5 pueda procesar más de 1.000 páginas web y documentos en Cody, a pesar de su capacidad de sólo 4.096 tokens? Con los avances en el campo de la IA generativa, proporcionar contexto no significa simplemente alimentar todo el documento tal cual a modelos lingüísticos como GPT-3.5 Turbo. Para preprocesar los datos se utilizan procesos backend como el chunking, los embeddings y las bases de datos vectoriales, que mantienen la relevancia dentro de los trozos y permiten al modelo navegar por la ventana de contexto predefinida.

En el escenario actual, una ventana de contexto más grande mejoraría el rendimiento general de la IA al acomodar entradas más grandes y complejas, reduciendo al mismo tiempo el número de transacciones de vector-almacenamiento necesarias para generar una respuesta. Dado que la ventana de contexto abarca tanto la entrada como la salida, una ventana más amplia también permitiría al modelo ofrecer respuestas elaboradas y coherentes manteniendo el contexto conversacional.

Una ventana de contexto más amplia también ayudaría a mitigar las alucinaciones que pueden producirse cuando se supera el límite de tokens en una conversación.

GPT-3.5 Turbo 16K frente a GPT-4

Aunque gpt-3.5-turbo-16k es la última versión de OpenAI, gpt-4 sigue superándola en varios aspectos, como la comprensión del contexto visual, la mejora de la creatividad, la coherencia y el rendimiento multilingüe. La única área en la que GPT-3.5-16k destaca es la ventana contextual, ya que GPT-4 está disponible actualmente en la variante de 8k, mientras que la variante de 32k se está lanzando gradualmente.

Mientras tanto, hasta que la versión de 32k de gpt-4 sea ampliamente accesible, la GPT-3.5-16k destaca por su mayor ventana contextual. Si busca específicamente un modelo que ofrezca una ventana contextual más amplia, el GPT-3.5-16k es la opción ideal.

Casos de uso de una ventana contextual más grande

- Atención al cliente: Una ventana contextual más amplia mejora la memoria a corto plazo del modelo, lo que lo hace muy adecuado para aplicaciones de atención al cliente, cumplimentación de formularios y recogida de datos de usuarios. Permite al modelo mantener el contexto durante un periodo más largo, lo que da lugar a respuestas más pertinentes a las entradas de los usuarios, como nombres, ID de clientes, quejas y comentarios.

- Formación de empleados: Aprovechar Cody para formar a los empleados resulta muy eficaz. La formación de los empleados suele implicar una gran cantidad de datos relacionados con las actividades, los pasos y los procesos empresariales. Para mantener la relevancia contextual a lo largo del programa de formación, se hace necesario incorporar todo el historial de conversaciones del alumno. Una ventana de contexto más amplia permite incluir más información histórica, lo que facilita una experiencia de formación más completa y eficaz.

- Análisis de datos: Las tareas relacionadas con el análisis financiero y la inferencia estadística suelen requerir el procesamiento de grandes volúmenes de datos para extraer conclusiones significativas. Con una ventana de contexto mayor, el modelo puede retener más información relevante durante el cálculo, lo que da lugar a un análisis más coherente y preciso. Por ejemplo, la comparación de balances y del rendimiento global de una empresa año tras año puede ejecutarse de forma más eficaz con una ventana de contexto más amplia.

Comparación entre GPT-3.5 4K v/s 16K

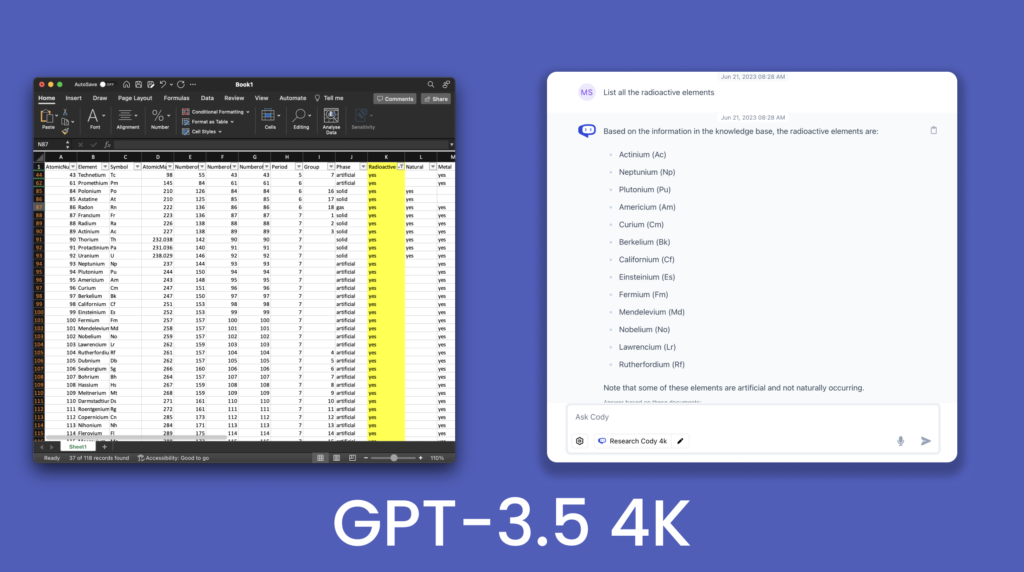

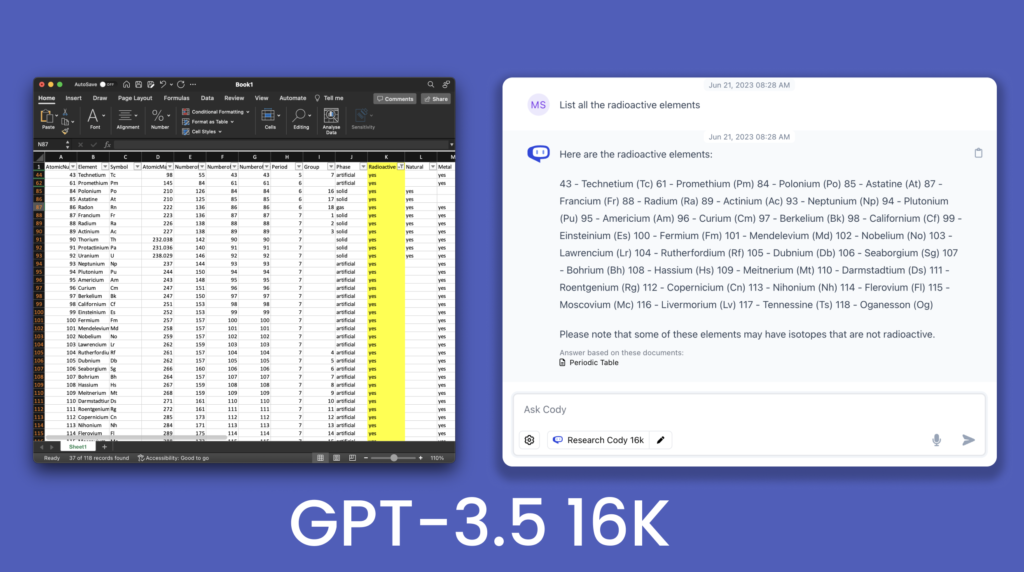

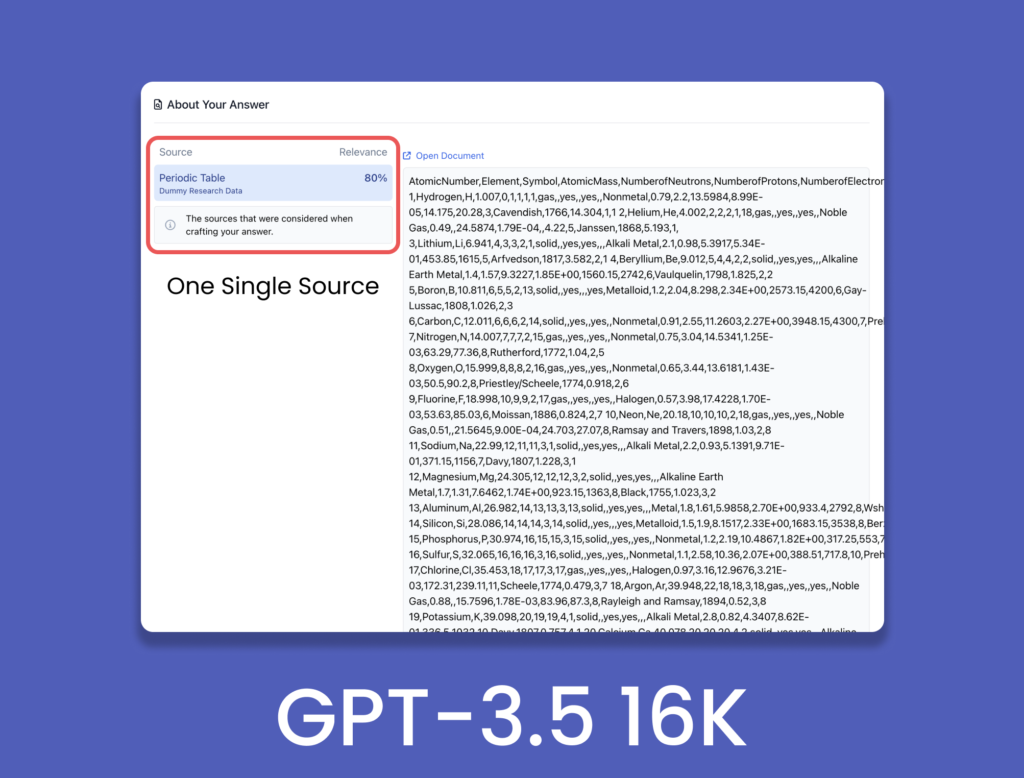

Para demostrar las mejoras en el modelo de 16K, consultamos un archivo .csv de la Tabla Periódica que contiene 118 elementos y sus características.

De la comparación se desprende que GPT-3.5 4K fue incapaz de producir todos los elementos radiactivos en su respuesta y omitió algunos elementos. En cambio, GPT-3.5 16K produjo casi todos los elementos radiactivos presentes en la tabla proporcionada. Esto demuestra la mejor elaboración de las respuestas gracias a la mayor ventana de contexto. Esto ha sido sólo un pequeño vistazo al potencial que encierra la ventana contextual de 16k, con infinitas aplicaciones e implementaciones de la misma. Con GPT-4 32K en el pipeline, el modelo 16K puede facilitar una transición más suave a una ventana de contexto mayor.

¿Actualización?

La ventana contextual más grande es sin duda una actualización significativa y no un mero truco. La mejora de la comprensión del contexto desempeña un papel crucial en la mejora de la calidad de las respuestas, y una ventana de contexto más amplia desbloquea un potencial sustancial para estos modelos lingüísticos (LLM). Al permitir una comprensión más amplia de la historia de la conversación y de las pistas contextuales, los LLM pueden ofrecer resultados más precisos y adecuados al contexto.

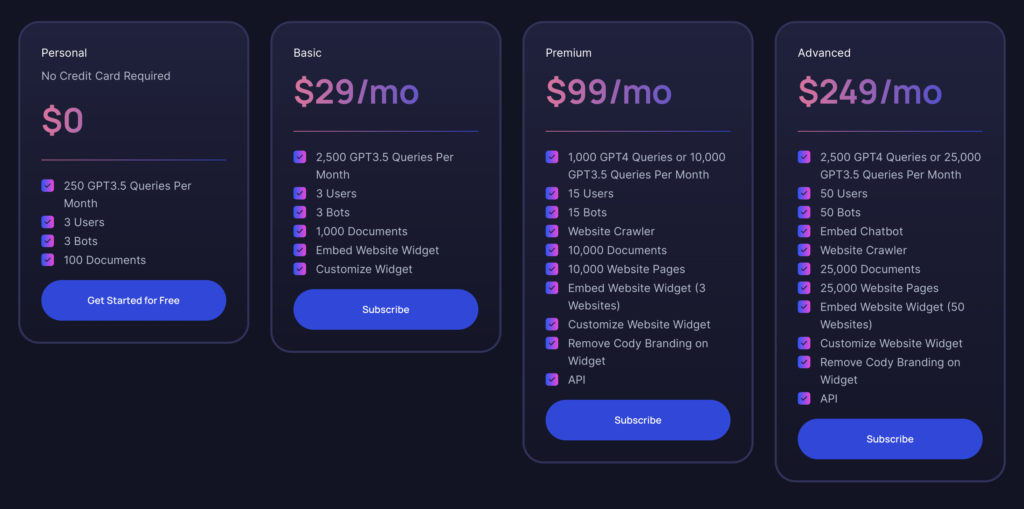

Como ya se ha mencionado, la variante 16K de GPT-3.5 está disponible para todos los usuarios a partir del Plan Básico. Si llevas algún tiempo utilizando el plan Personal (gratuito), ya habrás experimentado las posibilidades que ofrece Cody. El Plan Básico ofrece una excelente relación calidad-precio, sobre todo si no necesita las funciones adicionales de GPT-4. Es adecuado para particulares que estén construyendo un bot como proyecto o prototipo para su negocio, con la opción añadida del modelo GPT-3.5 16K. En el futuro, cuando lancemos la variante GPT-4 32K, siempre podrás pasarte al plan Premium cuando necesites más tokens.

Para las grandes empresas, el Plan Avanzado es la opción más potente, ya que satisface las necesidades de uso intensivo de recursos y de gran volumen. Ofrece capacidades integrales para satisfacer las exigencias de las operaciones a gran escala.