Die Leistungsfähigkeit von GPT-3.5 16K

Sollten Sie auf die kostenpflichtige Version von Cody upgraden? Hier ist der Grund, warum Sie das tun sollten.

Vor ein paar Tagen haben wir direkt nach der Veröffentlichung von OpenAI ein neueres Modell für alle unsere zahlenden Nutzer freigegeben: GPT-3.5 16k. So einschüchternd es auch klingen mag, es könnte für Ihr Unternehmen eine entscheidende Wende bedeuten. In diesem Blog werden wir uns mit den Anwendungsfällen von GPT-3.5 16k befassen, seine Vorteile erforschen und aufzeigen, wie es sich von dem bestehenden GPT-3.5-Modell und dem neuesten High-End-Modell GPT-4 unterscheidet.

Was ist GPT-3.5 16K?

Wenn Sie die kostenlose Version von Cody bereits verwendet haben, sind Sie vielleicht bereits mit dem GPT-3.5-Modell vertraut, das das gpt-3.5-turbo -Modell von OpenAI verwendet. Dieses Modell ist bei vielen Nutzern die beliebteste Wahl, da es in den meisten Fällen erschwinglich, schnell und zuverlässig ist. Der GPT-3.5-16k hingegen nutzt das Modell gpt-3.5-turbo-16k von OpenAI, das eine Erweiterung des gpt-3.5-turbo ist. Der wesentliche Unterschied liegt in dem Aspekt “16k”.

Was sind 16K?

Das Suffix “16K” bedeutet, dass das Modell ein Kontextfenster von 16.000 Token hat, was eine erhebliche Steigerung gegenüber den bisherigen 4.096 Token darstellt. In unserem letzten Blog haben wir ausführlich erklärt, was Token sind. Ein kleineres Kontextfenster in Modellen kann zu verschiedenen Einschränkungen führen, u. a:

- Mangelnde Relevanz: Bei einem begrenzten Kontextfenster kann das Modell Schwierigkeiten haben, den breiteren Kontext eines Gesprächs oder einer Aufgabe zu erfassen und relevant zu halten.

- Unfähigkeit, den Kontext beizubehalten: Ein kleineres Kontextfenster kann es für das Modell schwierig machen, sich an Informationen aus früheren Teilen eines Gesprächs zu erinnern und darauf zu verweisen, was zu Unstimmigkeiten und Schwierigkeiten bei der Aufrechterhaltung eines kohärenten Dialogs führt.

- Beschränkung der Länge von Eingabeanfragen: Kürzere Kontextfenster erzwingen eine Beschränkung der Länge von Eingabeanfragen, was es schwierig macht, umfassende Informationen zu liefern oder komplexe Fragen zu stellen.

- Einschränkungen im Kontext der Wissensdatenbank: Ein kleineres Kontextfenster kann bei der Einbeziehung von Wissen aus relevanten Dokumenten in die Wissensdatenbank aufgrund der begrenzten Datenaufnahme Einschränkungen unterliegen.

Vorteile eines größeren Kontextfensters

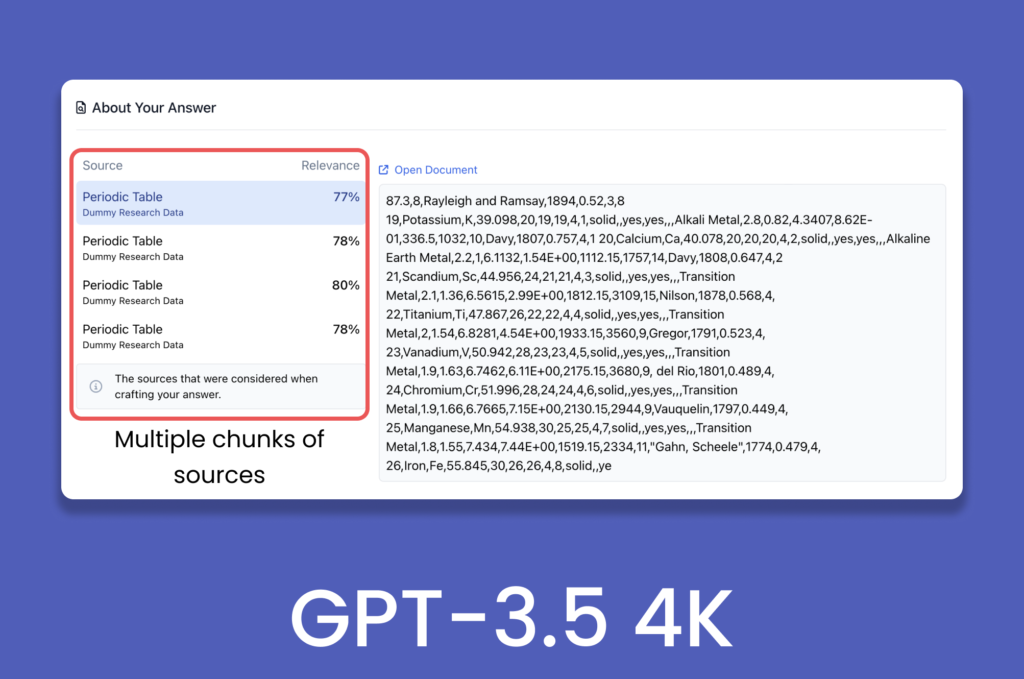

Manch einer mag sich fragen: Wie kann GPT-3.5 trotz seiner Kapazität von nur 4096 Token über 1000 Webseiten und Dokumente auf Cody verarbeiten? Mit den Fortschritten auf dem Gebiet der generativen KI bedeutet die Bereitstellung von Kontext nicht mehr, dass man einfach das gesamte Dokument in Sprachmodelle wie GPT-3.5 Turbo einspeisen muss. Backend-Prozesse wie Chunking, Embeddings und Vektordatenbanken werden zur Vorverarbeitung der Daten eingesetzt, um die Relevanz innerhalb der Chunks aufrechtzuerhalten und es dem Modell zu ermöglichen, im vordefinierten Kontextfenster zu navigieren.

Im aktuellen Szenario würde ein größeres Kontextfenster die Gesamtleistung der KI verbessern, da es größere und komplexere Eingaben aufnehmen kann und gleichzeitig die Anzahl der für die Erzeugung einer Antwort erforderlichen Vektor-Speichertransaktionen verringert. Da das Kontextfenster sowohl die Eingabe als auch die Ausgabe umfasst, würde ein größeres Fenster das Modell in die Lage versetzen, ausführliche und kohärente Antworten zu geben und gleichzeitig den Gesprächskontext zu erhalten.

Ein größeres Kontextfenster würde auch dazu beitragen, Halluzinationen abzuschwächen, die auftreten können, wenn das Token-Limit in einem Gespräch überschritten wird.

GPT-3.5 Turbo 16K vs. GPT-4

Obwohl gpt-3.5-turbo-16k die neueste Version von OpenAI ist, übertrifft gpt-4 sie in verschiedenen Aspekten wie dem Verständnis von visuellem Kontext, verbesserter Kreativität, Kohärenz und mehrsprachiger Leistung. Der einzige Bereich, in dem GPT-3.5-16k übertrifft, ist das Kontextfenster, da GPT-4 derzeit nur in der 8k-Variante verfügbar ist und die 32k-Variante noch schrittweise eingeführt wird.

In der Zwischenzeit, bis die 32k-Version von gpt-4 allgemein zugänglich wird, zeichnet sich das GPT-3.5-16k durch sein größeres Kontextfenster aus. Wenn Sie speziell nach einem Modell suchen, das ein größeres Kontextfenster bietet, ist das GPT-3.5-16k die ideale Wahl.

Anwendungsfälle für ein größeres Kontextfenster

- Kundenbetreuung: Ein größeres Kontextfenster verbessert das Kurzzeitgedächtnis des Modells, wodurch es sich gut für Anwendungen im Bereich des Kundensupports, des Ausfüllens von Formularen und der Erfassung von Benutzerdaten eignet. Dadurch kann das Modell den Kontext über einen längeren Zeitraum aufrechterhalten, was zu relevanteren Antworten auf Benutzereingaben wie Namen, Kunden-IDs, Beschwerden und Feedback führt.

- Mitarbeiterschulung: Die Nutzung von Cody für Mitarbeiterschulungen erweist sich als äußerst effektiv. Bei der Schulung von Mitarbeitern werden häufig umfangreiche Daten zu Geschäftsaktivitäten, -schritten und -prozessen erfasst. Um die kontextuelle Relevanz während des gesamten Trainingsprogramms aufrechtzuerhalten, ist es notwendig, die gesamte Gesprächsgeschichte des Auszubildenden einzubeziehen. Ein größeres Kontextfenster ermöglicht die Einbeziehung von mehr historischen Informationen, was eine umfassendere und effektivere Schulungserfahrung ermöglicht.

- Datenanalyse: Aufgaben, die Finanzanalysen und statistische Schlussfolgerungen beinhalten, erfordern oft die Verarbeitung großer Datenmengen, um sinnvolle Erkenntnisse zu gewinnen. Mit einem größeren Kontextfenster kann das Modell während der Berechnung mehr relevante Informationen speichern, was zu einer kohärenteren und genaueren Analyse führt. Der Vergleich von Bilanzen und der Gesamtleistung eines Unternehmens im Jahresvergleich kann beispielsweise mit einem größeren Kontextfenster effektiver durchgeführt werden.

Vergleich zwischen GPT-3.5 4K vs. 16K

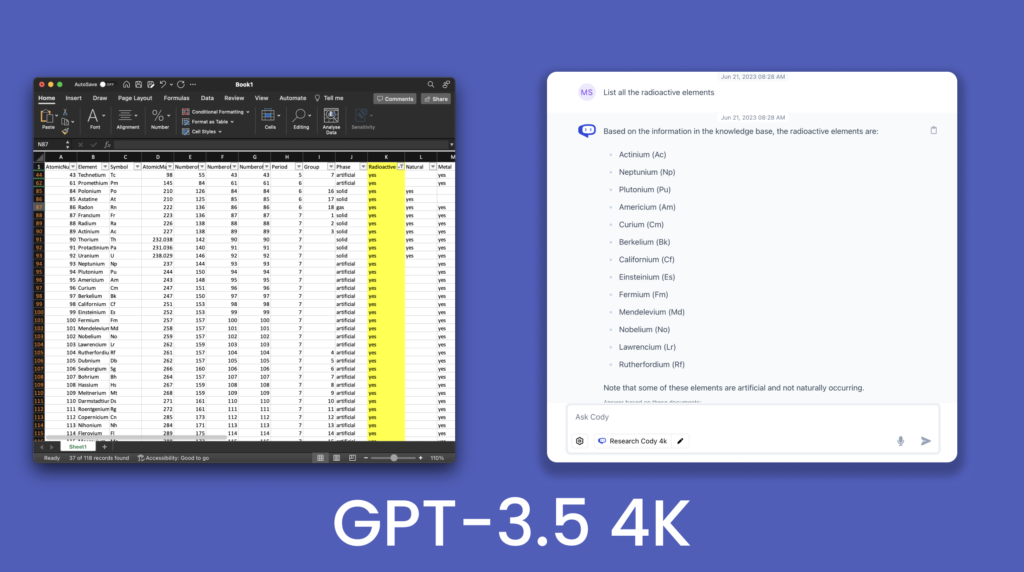

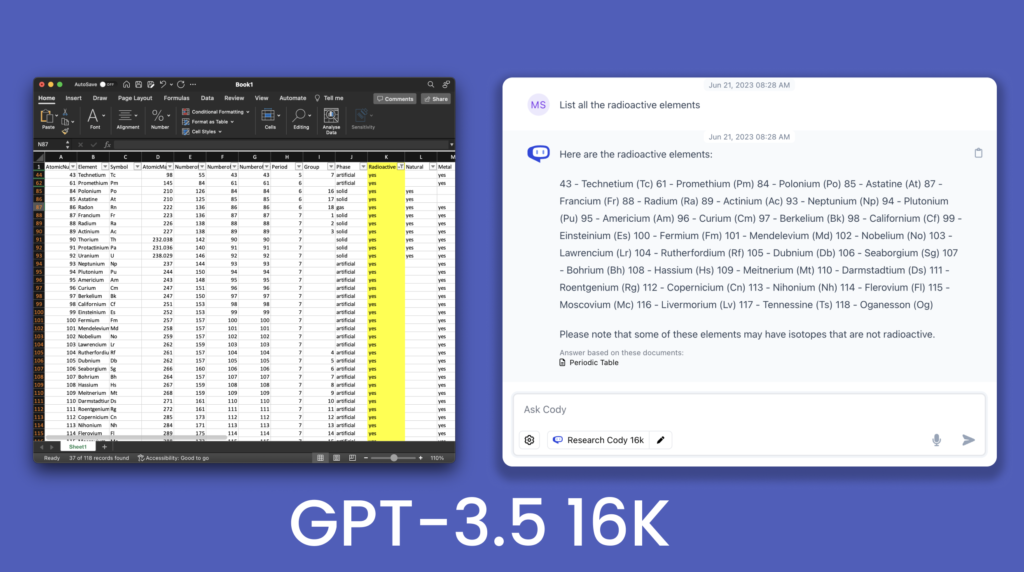

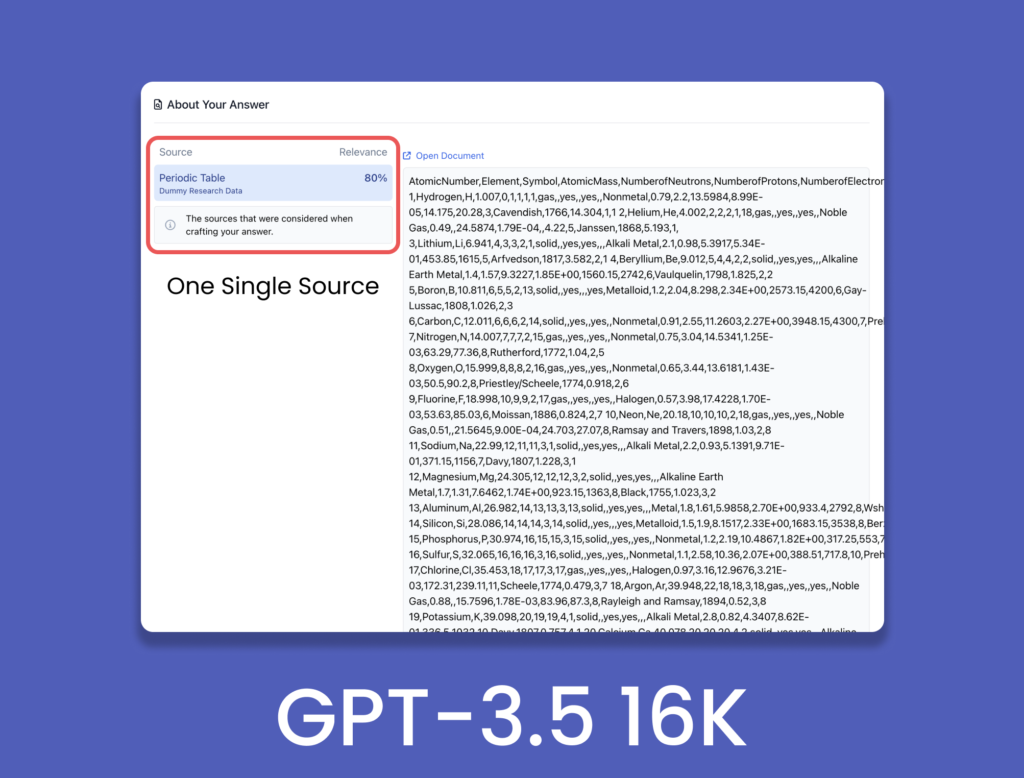

Um die Verbesserungen gegenüber dem 16K-Modell zu demonstrieren, haben wir eine .csv -Datei des Periodensystems mit 118 Elementen und ihren Merkmalen abgefragt.

Aus dem Vergleich geht hervor, dass GPT-3.5 4K nicht in der Lage war, alle radioaktiven Elemente in seiner Antwort zu produzieren und einige Elemente ausließ. Im Gegensatz dazu produzierte GPT-3.5 16K fast alle radioaktiven Elemente, die in der Tabelle aufgeführt sind. Dies verdeutlicht die verbesserte Ausarbeitung der Antworten aufgrund des größeren Kontextfensters. Dies war nur ein kleiner Einblick in das Potenzial des 16k-Kontextfensters, für das es unzählige Anwendungen und Implementierungen gibt. Mit GPT-4 32K in der Pipeline kann das 16K-Modell einen sanfteren Übergang zu einem größeren Kontextfenster ermöglichen.

Sollten Sie aufrüsten?

Das größere Kontextfenster ist zweifelsohne eine wichtige Neuerung und nicht nur eine Spielerei. Ein verbessertes Kontextverständnis spielt eine entscheidende Rolle bei der Verbesserung der Qualität der Antworten, und ein größeres Kontextfenster eröffnet ein erhebliches Potenzial für diese Sprachmodellmodelle (LLMs). Indem sie ein umfassenderes Verständnis des Gesprächsverlaufs und der kontextuellen Hinweise ermöglichen, können LLMs genauere und kontextgerechte Ergebnisse liefern.

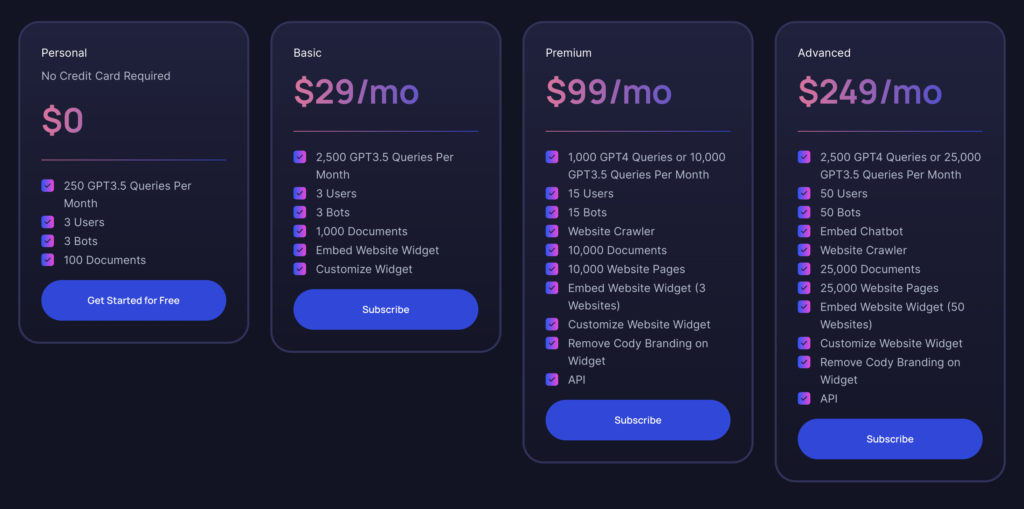

Wie bereits erwähnt, ist die 16K-Variante von GPT-3.5 für alle Nutzer ab dem Basic Plan verfügbar. Wenn Sie bereits seit einiger Zeit den (kostenlosen) Personal Plan nutzen, haben Sie die Möglichkeiten von Cody bereits kennengelernt. Der Basic Plan bietet ein hervorragendes Preis-Leistungs-Verhältnis, insbesondere wenn Sie die zusätzlichen Funktionen von GPT-4 nicht benötigen. Er eignet sich für Einzelpersonen, die einen Bot als Projekt oder Prototyp für ihr Unternehmen bauen, mit der zusätzlichen Modellauswahl von GPT-3.5 16K. Wenn wir in Zukunft die GPT-4 32K-Variante auf den Markt bringen, können Sie jederzeit auf den Premium-Plan upgraden, wenn Sie mehr Token benötigen.

Für größere Unternehmen ist der Advanced Plan die leistungsstärkste Option, die auf ressourcenintensive und hochvolumige Nutzungsanforderungen zugeschnitten ist. Es bietet umfassende Funktionen, die den Anforderungen von Großeinsätzen gerecht werden.