LLaMA 2: Metas Open-Source-KI-Modell

Ist der neueste LLM-Studiengang der Stadt den Hype wert?

Vor ein paar Tagen hat Meta in Zusammenarbeit mit Microsoft die neueste Version von LLM namens Llama 2 veröffentlicht. Wenn Sie den Hype um den LLM verfolgt haben, haben Sie vielleicht schon davon gehört oder sogar über seine neuen Funktionen gelesen. Um die Dinge zu vereinfachen, werden wir vier Gründe auflisten, warum Llama 2 so viel Aufsehen erregt und wie es im Vergleich zu einigen der besten LLMs abschneidet.

Frei für Forschung und kommerzielle Nutzung

Ein wichtiger Grund, der das Interesse der Menschen an Llama 2 geweckt hat, ist die Tatsache, dass Meta das gesamte Modell für fast jeden kostenlos zur Verfügung stellt, mit Ausnahme einiger großer Unternehmen, für die bestimmte Bedingungen gelten. Dieser Schritt eröffnet spannende Möglichkeiten für Einzelpersonen, die ein eigenes Unternehmen gründen oder sich in die Welt der generativen KI wagen wollen. Jetzt ist der perfekte Zeitpunkt, um in die Gewässer der KI einzutauchen, zumal ein Sprachmodell dieses Kalibers frei zugänglich ist. Zwar gab es bereits mehrere Open-Source-Modelle, aber keines davon stammte von einem Unternehmen der Größe Metas und konnte als direkter Konkurrent von GPT dienen.

“Es gab öffentliche Veröffentlichungen von vortrainierten LLMs (wie BLOOM (Scao et al., 2022), LLaMa-1 (Touvron et al., 2023) und Falcon (Penedo et al., 2023)), die die Leistung von geschlossenen vortrainierten Wettbewerbern wie GPT-3 (Brown et al., 2020) und Chinchilla (Hoffmann et al., 2022), aber keines dieser Modelle ist ein geeigneter Ersatz für geschlossene “Produkt”-LLMs wie ChatGPT, BARD und Claude.” – Meta-Forschungspapier

Sicherheit

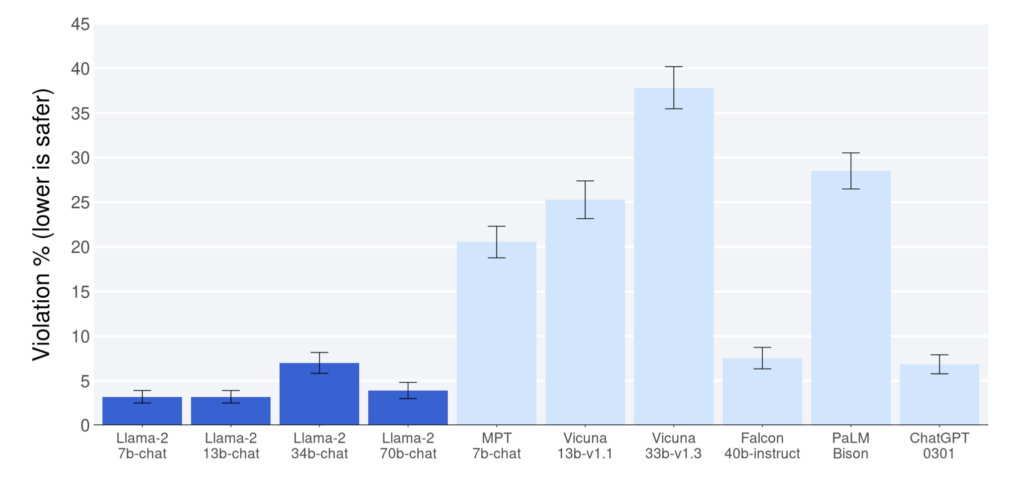

Ausgehend von den in der Meta-Forschungsarbeit veröffentlichten Berichten hat Llama 2 im Vergleich zu anderen Open-Source-Modellen eine überlegene Leistung bei der Bewertung von Hilfsbereitschaft und Sicherheit gezeigt. In diesen Punkten hat es sogar ChatGPT (Modelle 7b, 13b, 70b) überflügelt. Es ist jedoch wichtig, darauf hinzuweisen, dass in der Forschungsarbeit die Möglichkeit von verzerrten Daten zugunsten von Llama 2 eingeräumt wird, was bei der Interpretation der Ergebnisse berücksichtigt werden sollte. Aber auch wenn Llama 2 dem ChatGPT-Benchmark nahe kommt, verdient es ein Lob.

Einer der wichtigsten Faktoren, die zur Sicherheit von Llama 2 beitragen, ist der Datenschutz. Im Gegensatz zu anderen Modellen ist es bei Llama 2 nicht erforderlich, Ihre Daten an einen externen Server, wie z. B. OpenAI, zu senden, um Antworten abzurufen. Diese einzigartige Eigenschaft macht das Modell besonders wertvoll für kritische und sensible Anwendungsfälle, da es hilft, die Daten der Nutzer zu schützen und ihre Privatsphäre zu wahren. Die Nutzer können das Modell auf privaten Servern laufen lassen, wobei die Daten in ihrer eigenen Infrastruktur bleiben.

Offene Quelle

Die gängigsten LLMs, die derzeit im Einsatz sind, funktionieren als Blackboxen, in deren Funktionsweise die Nutzer nur begrenzt Einblick haben. Im Gegensatz dazu bieten Open-Source-Modelle einen transparenten Ansatz, der es den Nutzern ermöglicht, ihre innere Funktionsweise zu verstehen. Diese Transparenz schafft Vertrauen und Gewissheit bei der Verwendung solcher Modelle, trotz der Herausforderungen, mit denen sie konfrontiert sein können, wie z. B. die Erzeugung von Spam oder Desinformationen.

Darüber hinaus fördert der Open-Source-Charakter dieser Modelle die Zusammenarbeit und führt zu einer kontinuierlichen Verbesserung und Weiterentwicklung im Bereich der LLM. Folglich spielen Open-Source-Modelle eine entscheidende Rolle bei der Weiterentwicklung von Sprachmodellen.

“Und wir glauben, dass es sicherer ist. Die Öffnung des Zugangs zu den heutigen KI-Modellen bedeutet, dass eine Generation von Entwicklern und Forschern diese unter Stressbedingungen testen kann, um Probleme schnell zu erkennen und zu lösen – als Gemeinschaft. Indem wir sehen, wie diese Tools von anderen genutzt werden, können unsere eigenen Teams von ihnen lernen, diese Tools verbessern und Schwachstellen beheben.” – Meta-Website

Obwohl Llama 2 offen lizenziert ist, hat Meta die Daten, auf denen es trainiert wurde, immer noch nicht offengelegt, was im Hinblick auf den Datenschutz der Meta-Nutzer immer noch auffällt. Meta sagt, es habe sich bemüht, Daten von bestimmten Websites zu entfernen, von denen bekannt ist, dass sie eine große Menge an persönlichen Informationen über Privatpersonen enthalten” in der Llama 2-Forschungsarbeit, aber es hat nicht aufgeführt, welche Websites das sind.

Leistung

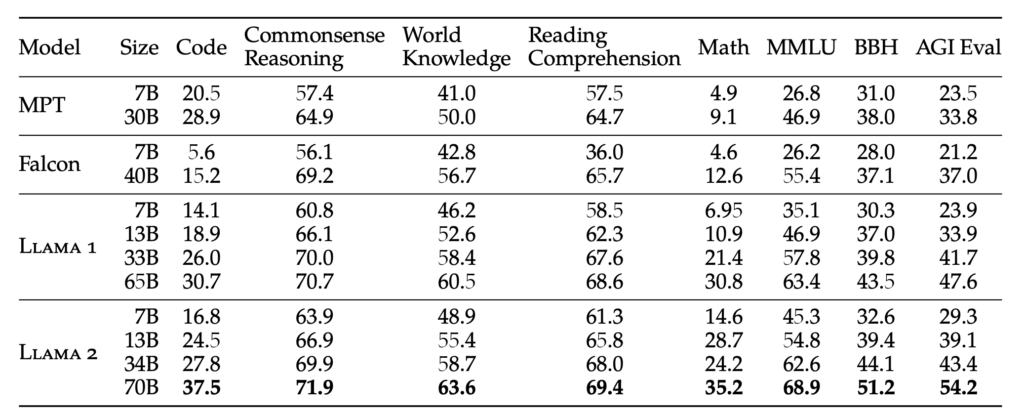

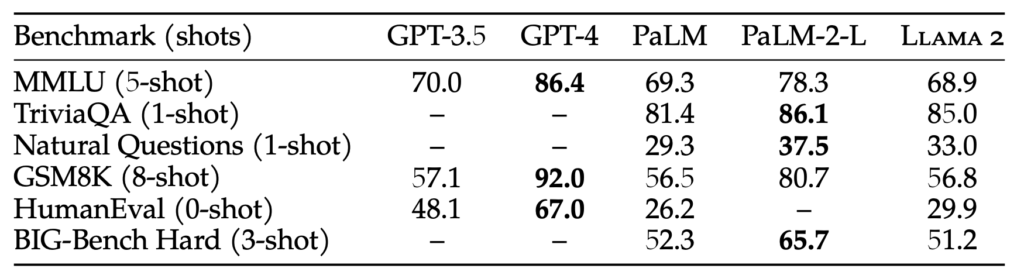

Llama 2 ist in vier verschiedenen Gewichten erhältlich: 7B, 13B, 34B und 70B. Das Gewicht gibt die Anzahl der Parameter an, mit denen das Modell trainiert wurde. Im Allgemeinen führen größere Parametergrößen zu genaueren und zuverlässigeren Antworten, aber sie erfordern auch mehr Rechenressourcen. Um die menschenähnlichen Eigenschaften des Modells zu verbessern, wird Llama 2 mit Hilfe von Befehlsabstimmung und der RLHF-Methode (Reinforcement Learning with Human Feedback), die auch von GPT verwendet wird, feinabgestimmt.

Die 70B Parametergröße ist zwar beachtlich, aber immer noch zu wenig im Vergleich zu GPT-3.5, das 175B Parametergröße hat. Infolgedessen kann die Leistung von Llama 2 zwar nicht mit der von GPT-3.5 mithalten, aber Benchmark-Tests zeigen, dass es trotz der geringeren Parametergröße ein enger Konkurrent ist. Trotz dieses Unterschieds übertrifft Llama 2 alle derzeit erhältlichen Open-Source-Modelle.

“RLHF ist ein Modelltrainingsverfahren, das auf ein fein abgestimmtes Sprachmodell angewandt wird, um es noch weiter an die Modellverhalten mit menschlichen Präferenzen und Befolgung von Anweisungen. Wir sammeln Daten, die empirisch ermittelte menschliche Präferenzen darstellen, wobei die menschlichen Kommentatoren auswählen, welche von zwei Modellausgaben sie bevorzugen. Dieses menschliche Feedback wird anschließend verwendet, um ein Belohnungsmodell zu trainieren, das Muster in den Präferenzen der menschlichen Annotatoren erlernt und dann Präferenzentscheidungen automatisieren kann.” – Meta-Forschungspapier

Schlussfolgerung

Es gibt tatsächlich eine Vielzahl von Open-Source-Modellen, und mit der Veröffentlichung von Llama 2 scheinen die Möglichkeiten grenzenlos zu sein. Es wird zwar noch einige Zeit dauern, bis diese Open-Source-Modelle mit einem so fortschrittlichen Modell wie GPT-4 konkurrieren können, aber die Spannung liegt darin, ein Modell zu bekommen, das an die Fähigkeiten von GPT-3.5 heranreicht. Dieser Fortschritt ist an sich schon bemerkenswert.

Da die LLM-Schulung immer effizienter wird, ist die Aussicht auf ein personalisiertes ChatGPT, das auf Ihre Daten auf Ihrem lokalen Gerät abgestimmt ist, eine verlockende Aussicht. Eine Plattform, die solche Möglichkeiten bietet, ist Cody, ein intelligenter KI-Assistent, der darauf zugeschnitten ist, Unternehmen in verschiedenen Bereichen zu unterstützen. Ähnlich wie ChatGPT kann Cody auf Ihre Geschäftsdaten, Ihr Team, Ihre Prozesse und Ihre Kunden geschult werden, wobei Ihre einzigartige Wissensbasis genutzt wird.

Mit Cody können Unternehmen die Leistung der KI nutzen, um einen personalisierten und intelligenten Assistenten zu schaffen, der speziell auf ihre Bedürfnisse zugeschnitten ist. Das macht Cody zu einer vielversprechenden Ergänzung in der Welt der KI-gesteuerten Unternehmenslösungen.

Klicken Sie hier, um das Meta Research Paper über Llama 2 zu lesen. Versuchen Sie Llama 2 hier.